Генератор robots.txt

Защита информации на вашем сайте – один из залогов успеха бизнеса в сети. Утечка данных с сайта, особенно личных данных пользователей, крайне негативно скажется на репутации компании. Поэтому при поисковом продвижении сайта нужно думать не только о том, какие страницы сайта должны попасть в ТОП поисковых систем, но и о том, какие не должны быть проиндексированы ни при каких обстоятельствах. Основной инструмент ограничения доступности информации для поисковых роботов – файл robots.txt.

Создание файла robots.txt

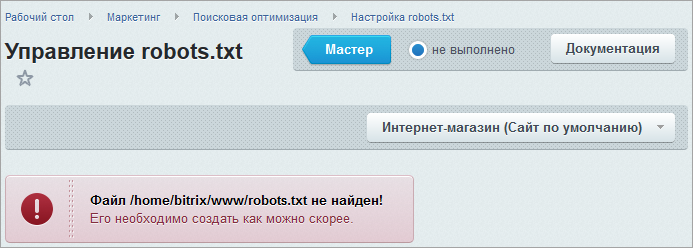

Начиная с версии 14.0.0 модуля Поисковая оптимизация, вам больше не потребуется создавать вручную файл robots.txt для вашего сайта. Теперь его создание можно выполнять с помощью специального генератора, который доступен на странице Управление robots.txt (Маркетинг > Поисковая оптимизация > Настройка robots.txt). Форма, представленная на данной странице, позволяет создать, управлять и следить за файлом robots.txt вашего сайта.

Если на сайте уже используется файл robots.txt, то в форме будет отображено его содержимое. Любая из инструкций (кроме User-Agent: *) может быть удалена, если навести на нее курсор мыши и нажать на "крестик". Если же файла robots.txt нет, то в системе будет выведено соответствующее предупреждение.

, для которого необходимо просмотреть/создать файл robots.txt.

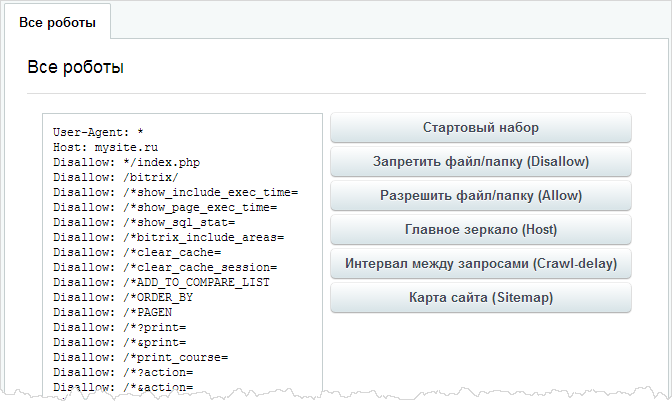

, для которого необходимо просмотреть/создать файл robots.txt.На вкладке Общие правила создаются инструкции, которые действуют для всех поисковых систем (ботов). Генерация необходимых правил осуществляется с помощью кнопок:

- Стартовый набор - создается базовый рекомендованный набор правил. Во время создания система запросит главное зеркало сайта. Укажите его и

стартовый набор отобразится в окне

.

.

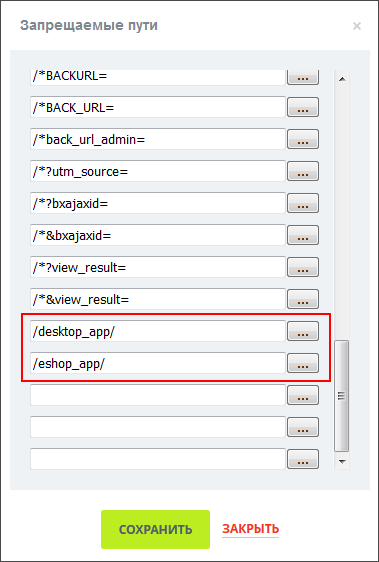

- Запретить файл/папку (Disallow) - позволяет дополнить рекомендованный список правил инструкциями, запрещающими индексировать тот или иной файл/папку. При нажатии на кнопку открывается окно, в котором отображаются уже существующие запрещающие инструкции. Добавим, например, еще

пару папок

, которые не должны индексироваться и нажимаем Сохранить. В конце списка файла

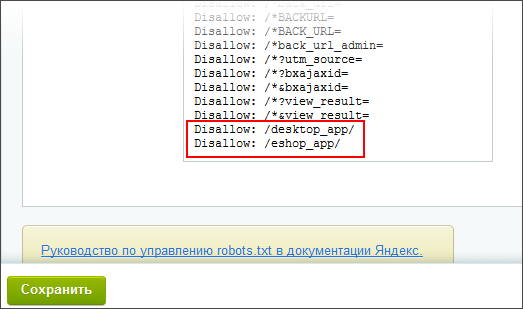

добавились новые правила

, которые не должны индексироваться и нажимаем Сохранить. В конце списка файла

добавились новые правила

.

. - Разрешить файл/папку (Allow) - позволяет добавить инструкции, показывающие, что тот или иной файл/папка должен быть проиндексирован. Правила задаются аналогично правилам запрета.

- Главное зеркало (Host) - служит для указания адреса главного зеркала сайта Обратите внимание, что при создании базового набора правил система уже запрашивала главное зеркало. Но если файл robots.txt был создан ранее и в нем не было указано зеркало, то с помощью данной кнопки вы можете его добавить. . Если зеркало доступно только по защищенному каналу, то необходимо отметить опцию https.

- Интервал между запросами (Crawl-delay) - служит для настройки временного интервала между запросами к страницам сайта. Данную настройку удобно использовать, например, в условиях низкой производительности, большой нагрузки на сервер.

- Карта сайта (sitemap) - позволяет указать путь к файлу карты сайта. Нажатие на кнопку Сохранить добавляет запись в файл.

Disallow: / .На вкладках с названием поисковой системы настраиваются специальные правила для ботов.

Если необходимо дописать инструкции в файл robots.txt вручную, то это можно выполнить на вкладке Редактировать.

Все вносимые изменения инструкций отображаются только в форме без записи в файл. Когда все правила внесены, нажмите кнопку Сохранить. Файл robots.txt создастся или перезапишется, если он уже существовал.

Набрав в адресной строке браузера http://ваш_сайт/robots.txt вы увидите содержимое только что сохраненного файла.

и Ваше мнение важно для нас