Администратор. Базовый

Для кого этот курс? |

Примерное время изучения курса – 14 часов 14 минут (без сдачи тестов, выполнения практических заданий и просмотра видео). |

Курс предназначен для базовой подготовки администраторов сайтов, созданных на «1С-Битрикс: Управление сайтом». Изучив курс, вы освоите основные методы администрирования системы, а также пополните знания по темам, изученным в курсе Контент-менеджер.

Если вы добросовестно изучите курс, то научитесь:

- управлять доступом к системе, сайтами, пользователями, группами пользователей;

- работать с инструментами системы;

- использовать возможности интерфейса по управлению системой;

- работать с модулями «1С-Битрикс: Управление сайтом», связанными с оптимизацией и безопасностью работы сайта;

- выполнять работу по конфигурированию веб-системы для оптимальной работы.

Если вам предстоит самостоятельная установка системы или перенос сайта на хостинг, то без курса

Установка и настройка

Курс Установка и настройка предназначен для специалистов, устанавливающих «1С-Битрикс: Управление сайтом» или «Битрикс24 в коробке».

Подробнее ...

вам не обойтись.

Начальные требования |

Необходимый минимум знаний для изучения курса:

- базовые навыки компьютерной грамотности и навыки работы с ОС Windows;

- базовые знания по HTML, WWW и организации доступа к веб-серверу;

- знание системы в рамках курса Контент-менеджер Мы считаем, что вы этот курс уже прошли и знаете многое о Битриксе. Поэтому подсказок во всплывающих окнах будет намного меньше, чем в курсе Контент-менеджер. , чтобы банально не путаться в интерфейсе.

Неплохо было бы иметь базовые навыки установки и администрирования *nix-систем и основы Баз Данных.

У нас часто спрашивают, сколько нужно заплатить |

Курс полностью бесплатен. Изучение курса, прохождение итоговых тестов и получение сертификатов – ничего из этого оплачивать не нужно.

|

|

Сертификация |

![]() После изучения курса пройдите тесты на сертификацию. При успешной сдаче линейки тестов скачайте сертификат об успешном прохождении курса в формате PDF со страницы Моё обучение.

После изучения курса пройдите тесты на сертификацию. При успешной сдаче линейки тестов скачайте сертификат об успешном прохождении курса в формате PDF со страницы Моё обучение.

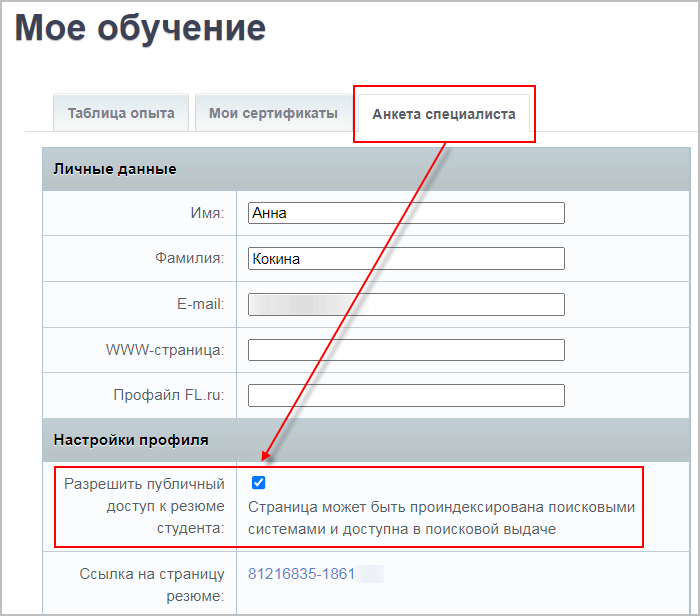

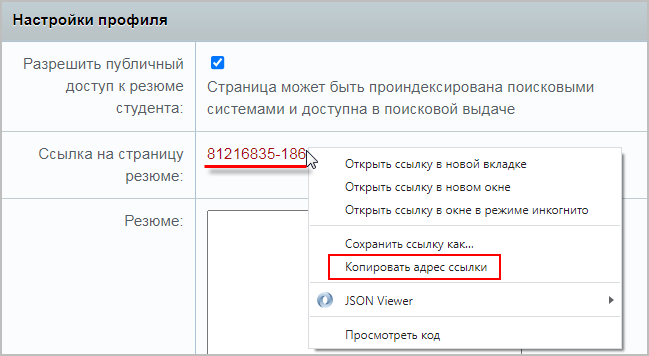

Также вы можете поделиться ссылкой на страницу со своими сертификатами. Для этого на странице Моё обучение отметьте опцию

Разрешить публичный доступ к резюме студента

и скопируйте

ссылку на страницу резюме

и скопируйте

ссылку на страницу резюме

. Страница с вашим резюме будет доступна всем, кому вы отправите ссылку на неё.

. Страница с вашим резюме будет доступна всем, кому вы отправите ссылку на неё.

Баллы опыта |

В конце каждого урока есть кнопка Прочитано!. При клике на неё в вашу итоговую таблицу опыта добавляется то количество баллов, которое указано в

прочитанном

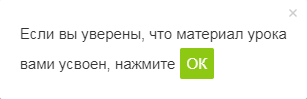

После нажатия кнопки Прочитано! появится

окно подтверждения:

уроке. В зависимости от количества набранных баллов опыта вам присваивается звание. Баллы опыта не влияют на получение сертификата.

уроке. В зависимости от количества набранных баллов опыта вам присваивается звание. Баллы опыта не влияют на получение сертификата.

Периодически мы заново оцениваем сложность уроков, увеличивая/уменьшая число баллов, добавляем новые уроки. Поэтому итоговое количество баллов курса и количество набранных вами баллов могут различаться между собой. Набранные вами баллы, в отличие от суммы баллов курса, не пересчитываются. Не переживайте!

Отличный результат – это если общее число набранных вами баллов отличается от максимального на несколько процентов.

|

|

Практика |

При изучении курса рекомендуется повторять описываемые действия на демонстрационной версии сайта, установленной локально или на хостинг.

Как проходить учебный курс? |

Для преподавания офлайн |

Если данный курс берётся в качестве основы для офлайнового преподавания, то рекомендуемая продолжительность: 2 дня (19 академических часов).