|

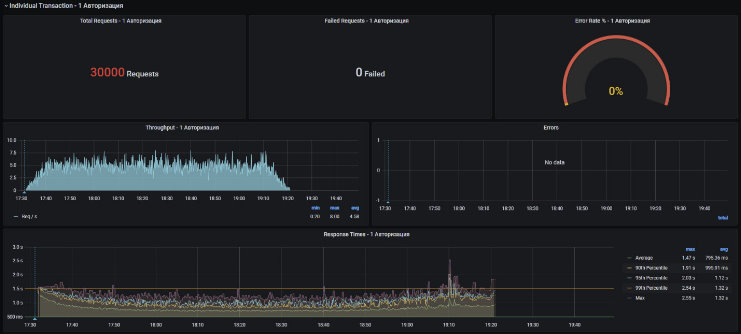

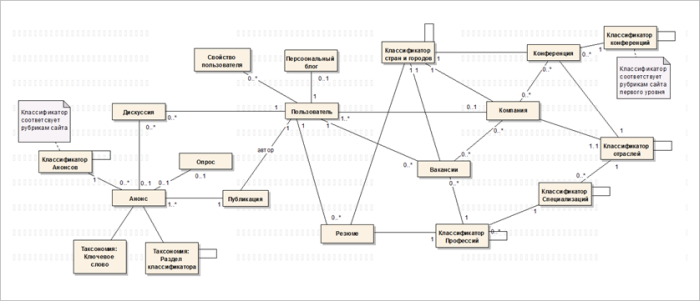

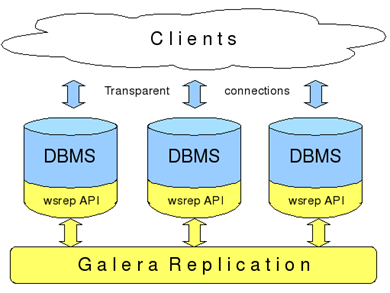

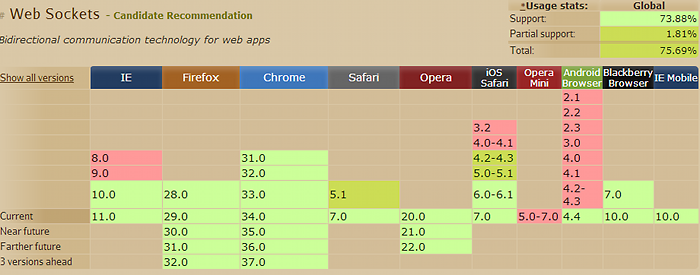

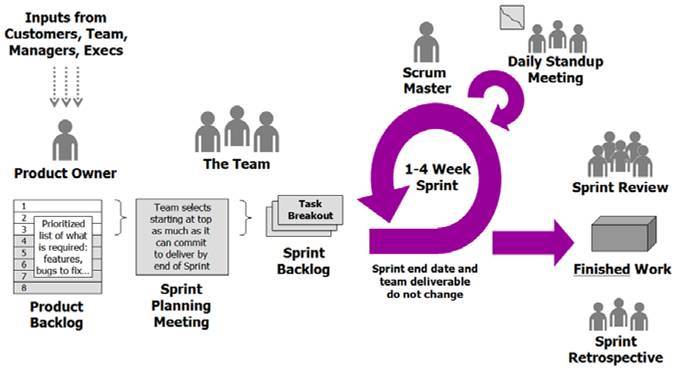

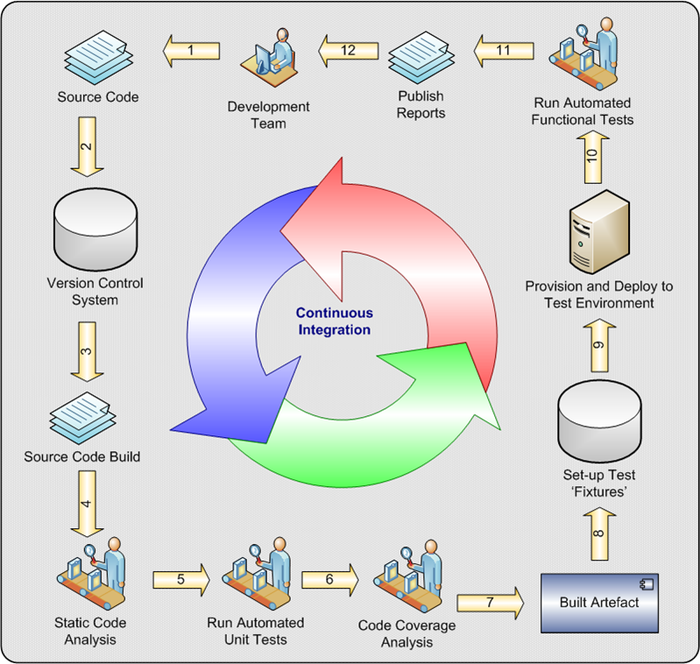

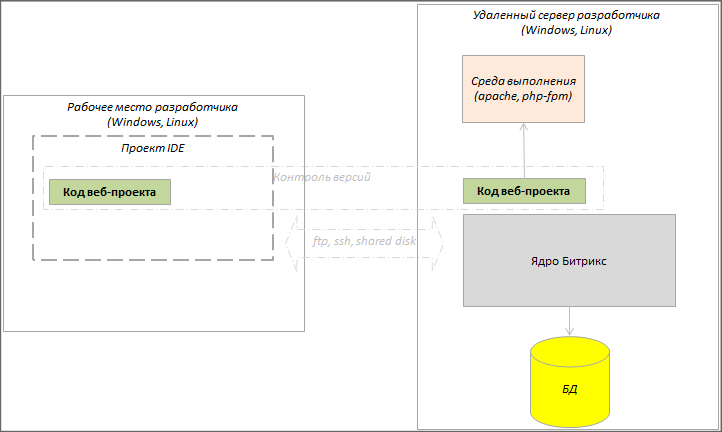

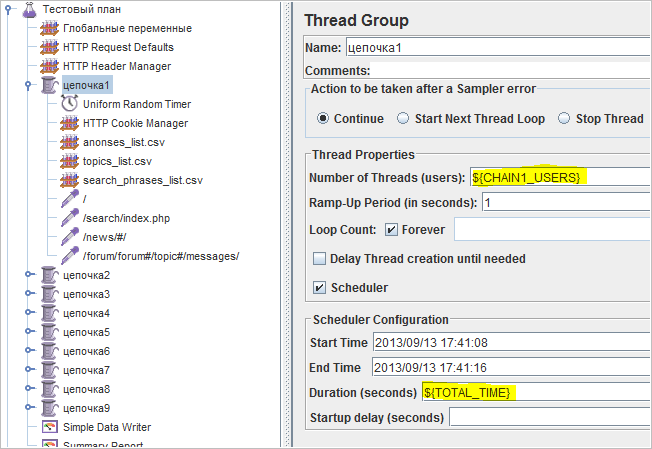

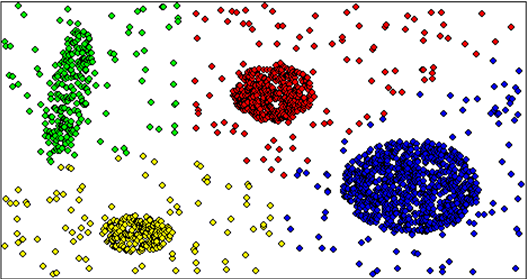

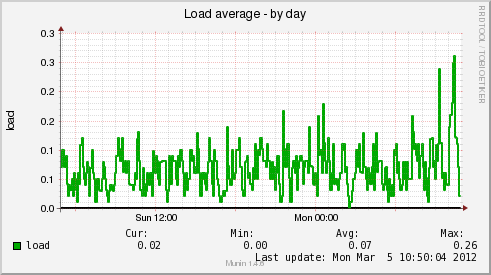

Пример отображения динамической схемы

|

|---|

|

Разработка и эксплуатация высоконагруженных проектов

Разработка проекта

Разработка высоконагруженного или сложного проекта серьёзно отличается от "типовой" работы по целому ряду параметров:

- наличия дополнительных этапов: прототипирование, например,

- более сложной и объёмной работы по написанию кода,

- необходимостью пересмотра подходов к архитектуре проектов,

- необходимостью созданию системы мониторинга,

- возможной необходимостью перехода с собственных разработок на какие-то фраймворки с целью сэкономить усилия на типовом функционале, которого нет в "загашниках" веб-студии,

- необходимостью освоения новых технологий, облачных, например.

Эти сложности могут привести к смене и стиля работы студии и технологии разработки, используемой до сегодняшнего момента.

В этой главе будут рассмотрены самые разные стороны процесса разработки сложного или высоконагруженного проекта.

Основные риски

Рассмотрим основные риски при работе с большими проектами:

Управленческие риски

Основной управленческий риск - это расхождение бизнес-целей и целей разработки, когда не найдено согласие между постановщиками задачи и теми, кому предстоит её решать.

К управленческим рискам можно отнести и организацию взаимодействия с заказчиком, организацию процесса производства в самой компании.

Детально управленческие риски рассмотрены в уроке Эффективная работа команды.

Риски проектирования

Забота о рисках проектирования лежит целиком на менеджере проекта. Это ещё один аргумент в пользу того, что им должен быть менеджер-технолог. Для уменьшения вероятности провала проекта необходимо составить "план управления рисками", который необходимо обсудить с клиентом. Для более точной оценки рисков необходимо провести тестирование на прототипе. Смоделируйте нагрузку и проверьте свои решения.

Типичные ошибки стратегии и тактики:

- Отсутствует видение системы: "Давайте начнем делать систему, а программисты придумают как это реализовать".

- При рассмотрении ТЗ менеджер проекта соглашается на любые модификации: ядра, админки, визредактора и т.п., в угоду бизнес-целям веб-студии.

- Менеджер проекта не уделяет проектированию и созданию прототипа должного значения.

- Вопрос производительности «закрывается» железом.

- Заказчик отказывается мыслить логически.

Чтобы избежать этих ошибок:

- При проектировании нужно разделить запрашиваемый заказчиком функционал на стандартный и нестандартный для используемой платформы.

- Проектировщик в деталях должен понимать, как реализовать стандартный функционал.

- Составьте логическую модель данных, глоссарий, кейсы использования. Растолкуйте их Клиенту.

- Сделайте Клиента участником проектной команды.

- Сделайте прототипы для снятия технических рисков (сложные технологии, нагрузка).

- Сделайте прототипы интерфейсов.

- Менеджер проекта должен вызубрить онлайн курсы по Bitrix Framework, если проект разрабатывается на Bitrix Framework.

Риски разработки

Риски разработки зависят от подготовки программистов, знания ими продукта, а также от стратегии и тактики разработки, выбранной менеджером проекта.

Типичные ошибки стратегии и тактики (убывание по важности):

- Не определена программная структура проекта.

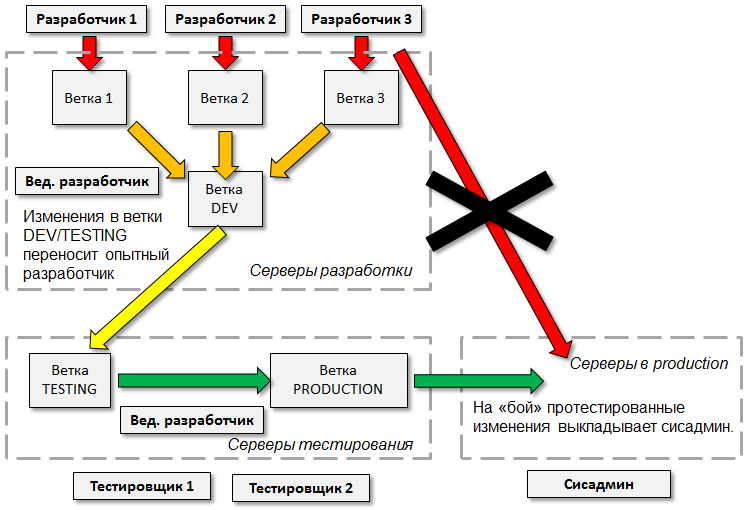

- Отсутствует, либо реально не работает система контроля версий.

- Бесконтрольное программирование на ООП. Создаётся сложная иерархия для решения проблемы, которую можно решить одним скриптом. Нерациональное использование трудовых ресурсов для решения задач.

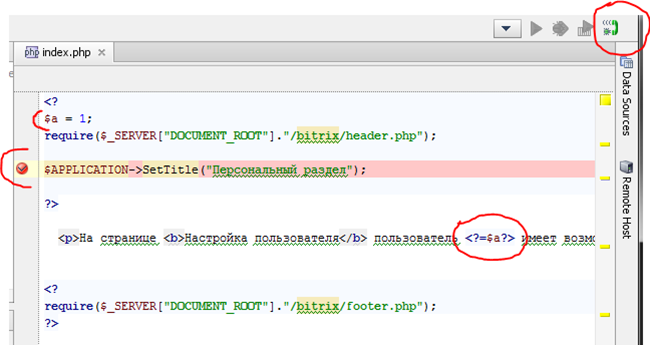

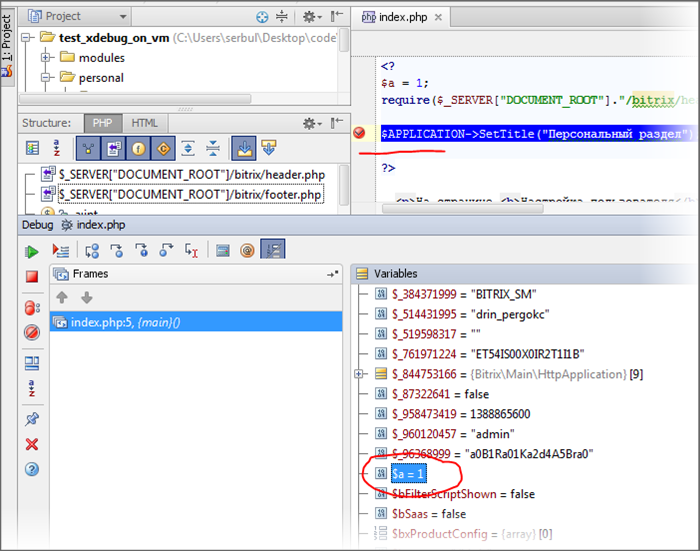

- Не используются инструменты отладки кода.

- Не регулируются права доступа на тестовых, боевых, девелоперских серверах: все сотрудники работают от root.

- "Секретные" объекты: агенты, обработчики, созданные самими разработчиками. Эти объекты могут быть недокументированы, располагаться где и как попало, что затрудняет дальнейший их поиск и отладку.

- Отправка транзакций на e-mail разработчику. Отключение этой нужной в ходе разработки функции может быть просто забыто.

- Отсутствие комментариев в коде.

- Лог-файлы размещаются в корне сайта.

Типичные ошибки при использовании собственно Bitrix Framework:

- Модификация ядра

- Прямые запросы в БД.

- Код пишется либо вне компонентов, либо в шаблонах компонентов. Объяснение: "так удобнее", вопреки идеологии Bitrix Framework.

- Настройки собственных, либо кастомизированных компонентов работают частично. После сдачи проекта им будет управлять администратор, и ему некогда, да и не должен он разбираться в собственно коде компонента.

- Огромные файлы кэша - не учтены все особенности кеширования. Встречается кеширование всего, что попало "под руку".

- Огромный init.php.

- Не оптимальное использование API Bitrix Framework, как правило, вызванное плохим знанием разработчиком API системы.

- Беспорядочный

/bitrix/php_interface/dbconn.php. - Обработчики событий переопределены везде, где можно, без комментариев зачем.

- Эксплуатационные параметры могут задаваться константами где угодно, на страницах, в компонентах, в классах модулей.

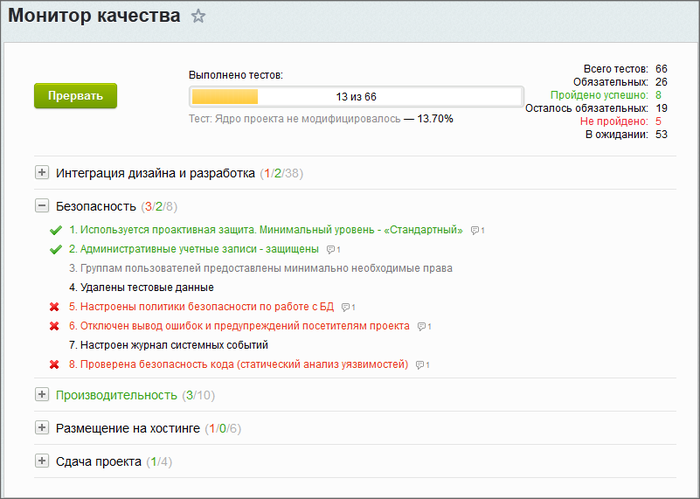

Информационная безопасность

Писать код "без дыр" крайне сложно и требует высокого профессионализма и большого опыта. Если в команде нет хотя бы одного такого высококлассного профессионала, способного проконтролировать написание кода остальными программистами, то использование Проактивной защиты должно стать для вас правилом.

API Bitrix Framework – защищено, написание кода в обход него всегда чревато если не текущими ошибками, то потенциальными проблемами, если вдруг обнаружится какая-то уязвимость.

Очень полезно использование сканера безопасности, который, конечно, не панацея, но позволяет выловить большинство ошибок.

Не забывайте перед сдачей проекта удалить тестовых пользователей, тестовые группы, тестовые файлы, лишние резервные копии. И обязательно использовать Монитор качества

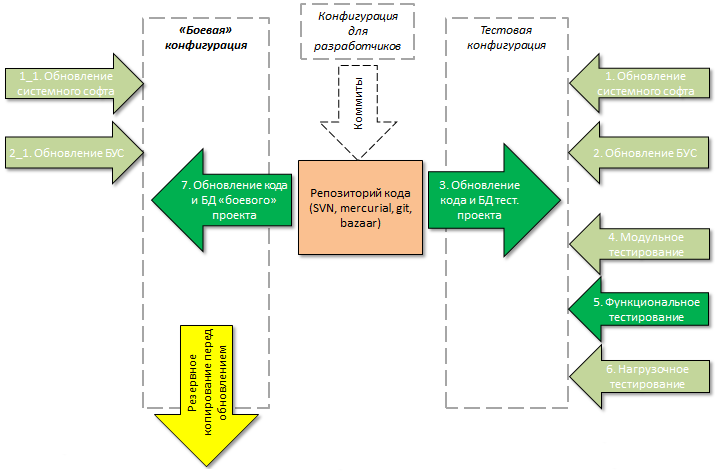

Эксплуатация

Банально, но: для эксплуатации высоконагруженного проекта нужен хороший системный администратор, способный оптимально настроить сервер. Администратор не должен "забывать" делать резервное копирование, обновлять софт.

При эксплуатации проекта менеджер проекта не должен допускать ни ситуации, когда разработчики ходят на сервера под правами root'а, ни ситуации когда права закрыты настолько, что разработчики не могут посмотреть логи сервера.

Видео

Подводные камни разработки - чего делать нельзя

Программная архитектура веб-систем на Битриксе: от простого сайта до веб-кластера

Особенности проектирования под Битрикс

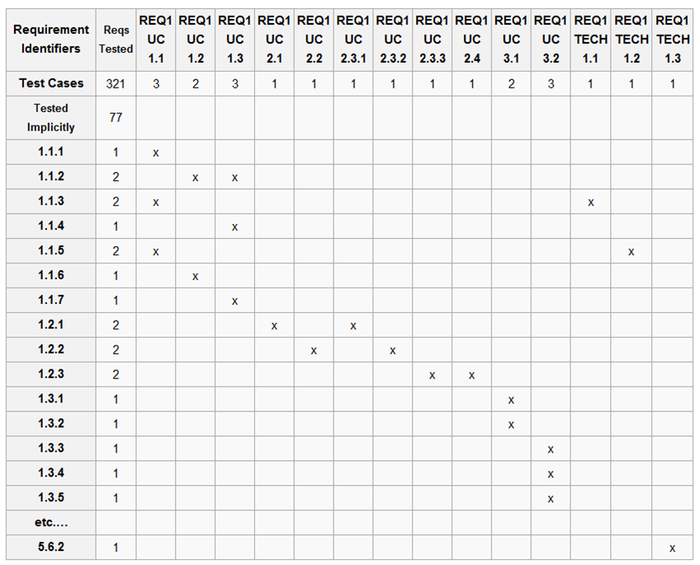

Сбор и анализ требований

Введение

Необходимый этап для любого проекта, но если в малых ещё можно что-то делать через постоянное обращение к клиенту: "делаем так?", то в случае большого или высоконагруженного проекта без проведения этого этапа в полном объёме реализовать проект невозможно.

Анализ требований действительно необходим, когда речь идет о больших сложных проектах со сроком разработки больше месяца. Необходимо вести предварительную работу, в которую входит настройка необходимых инструментов, налаживание связи с людьми заказчика, наиболее разбирающимися в сути вопроса, а также изучение самой предметной области сайта.

В случае сложной предметной области, возможно, заказчик сам не может толком собрать такие требования. Часто клиент приходит к исполнителю с "кашей" в голове. Этап сбора и анализа требований в этом случае - это упорядочивание и формальная регистрация этой "каши". И согласование полученного с клиентом.

В случае больших и сложных проектов этап сбора и анализа требований рекомендуется проводить отдельным пунктом в договоре с отдельной сметой и оплатой. Это обезопасит как клиента, так и исполнителя от недобросовестных или непрофессиональных действий.

Требования

Требования делятся на функциональные и нефункциональные, то есть описывающие поведение системы (требуемую функциональность) и различные особенности поведения или эксплуатации системы, например, требования к удобству использования, надежности, производительности и тому подобное.

Функциональные требования - это пользовательские сценарии, которые должны быть реализованы в системе. Если они работают так как нужно клиенту, то эти требования выполнены.

Нефункциональные требования оформляются отдельно и должны учитывать экстремальные особенности которые должна выдерживать система. Одним из самых оптимальных способов выполнения нефункциональных требований на данный момент является использование веб-кластера, решающего задачи отказоустойчивости (дублирует несколько узлов), масштабируемости (можно добавлять сервера приложений и базы данных), надёжности (данные распределены по нескольким машинам).

Как проводить сбор и анализ требований

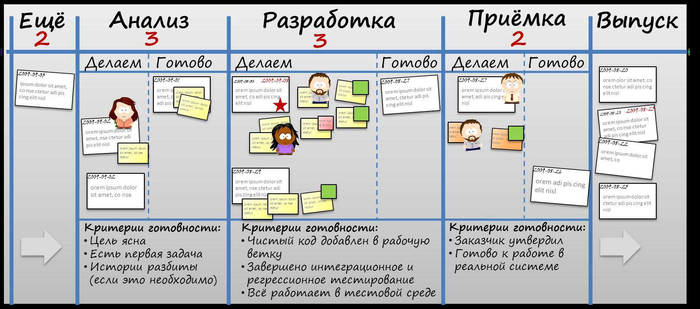

Сбор и анализ требований может быть (в случае больших и сложных проектов - должен быть) итерационным, пошаговым. В противном случае можно потерять очень много времени на данном этапе, для сложных систем (типа Softkey) - до года. В этом случае возникают свои риски: не учесть всего и встать перед необходимостью переделки.

Надо организовать с клиентом серию встреч в доверительной атмосфере. Клиент должен увидеть что вы не "отжимаете" деньги, а пытаетесь вместе с ним понять что ему нужно, решить его задачу эффективно, дёшево, быстро и максимально просто. Заказчик должен быть уверен, что он в любой момент может прийти, увидеть доступные документы по работе над его проектом. Это называется выстроить атмосферу Agile манифеста. В этом случае клиент будет максимально открыт, сообщать всё что он знает о проблеме.

Эта же мера позволит снизить риск формализации, когда стороны переводят общение в формат e-mail с целью фиксировать всё общение на случай непонимания и претензий. Такой подход сразу лишает стороны желания разбираться и понимать. Проектирование переходит в фазу юридических перестраховок, подстилания "соломки", что резко снижает вероятность удачной реализации проекта.

Без создания доверительной атмосферы возможны попытки клиента скрыть от разработчика бизнес-процесс и цели. Это когда задачи формулируются без разъяснения для чего это надо. Заказчик обрисовывает для себя проблему, но не зная принципов работы CMS и ее возможностей, придумывает решение, которое крайне сложно реализовать. А при этом эту же проблему можно решить совершенно иначе, например, проставлением галки где-то в админке. Но заказчик не объясняя для чего это надо, заявляет требование сделать именно то, что он придумал. В итоге разработчик тратит время впустую. Заказчик тратит деньги впустую.

Очень важно "качество" менеджера, занимающегося проектом со стороны исполнителя. Менеджер должен сам "прочувствовать и вжиться" в проект, должен научиться говорить с клиентом на его языке, на языке его предметной области, стать экспертом, "хранилищем знаний" для разработчиков. Менеджер должен научить предметной области ведущего разработчика или аналитика.

Методы и инструменты

Существует несколько методологий сбора и анализа требований. Существуют и разные инструменты сбора и анализа требований. Задача, которая стоит перед исполнителем - выбрать именно те методы и инструменты, которые подойдут к конкретному проекту. Максимально простые и эффективные методы и инструменты.

Есть несколько инструментов:

- Общий словарь терминов проекта. Например: "Ценовое предложение - это ...", "Цена - это ...", "Валюта - это..." и так далее. В этом случае, заказчик и исполнитель начинают говорить друг с другом на понятном языке. В больших проектах такой словарь может быть в несколько сотен терминов. В дальнейшем описание всех остальных документов ведется терминами словаря.

- Модель сущностей (классов) (Class\Object Diagram) определяем сущности системы:

Это статическая модель. На неё переносятся термины из словаря и устанавливаются связи и отношения между сущностями. Здесь потребуется серьёзная логическая работа со стороны Клиента. Он должен показать и обосновать почему эта связь есть, откуда она берётся. На больших проектах таких диаграмм может быть несколько (встречается до 10) и каждая охватывает какую-то часть системы.

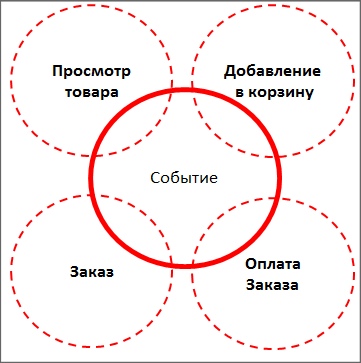

- Сценарии, Use Case или User story - динамическая модель системы. Описание поведения пользователей с определёнными ролями в системе.

В простом случае описываются просто цепочки действий, в более формальных случаях сложных предметных областей лучше использовать формат Сценария поведения.

- Story map - Упорядоченная карта выявленных требований. Расстановка приоритетов в выявленных требованиях: более срочные, главные и понятные пишутся наверху, менее важные, менее приоритетные, менее понятные - пишутся внизу.

Если требуется более глубокая проработка требований (это может потребоваться когда в проекте появляются какие-то алгоритмы вычисления, шифровки, работы банкоматов, корзины), то используются:

- Диаграмма деятельности (Activity Diagram) для "окольцовки" блок схем логики.

- Диаграмма состояний (State machine diagram) для описания состояний конечных автоматов, когда система может ходить между статусами. (Например, заказ в интернет-магазине.)

- Диаграмма последовательности (Sequence diagram) для упорядочивания по времени взаимодействия объектов (редко используемая диаграмма).

- Технические спецификации обмена данных – структура файлов импорта-экспорта и тому подобное.

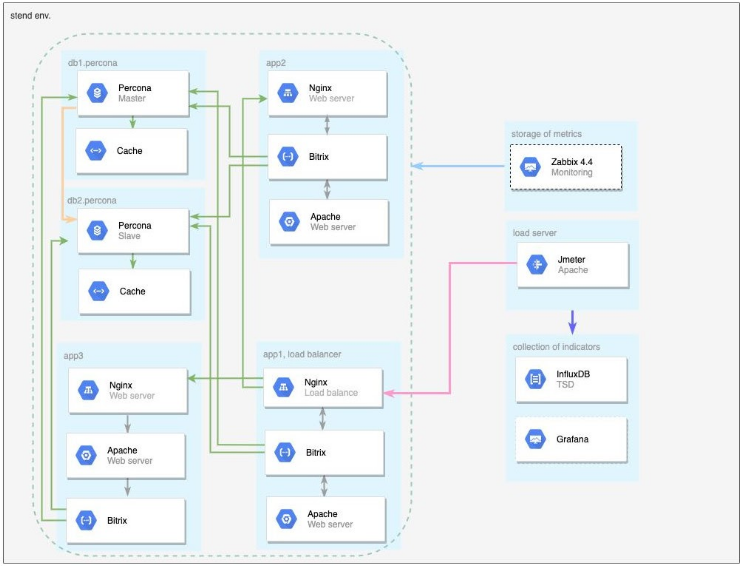

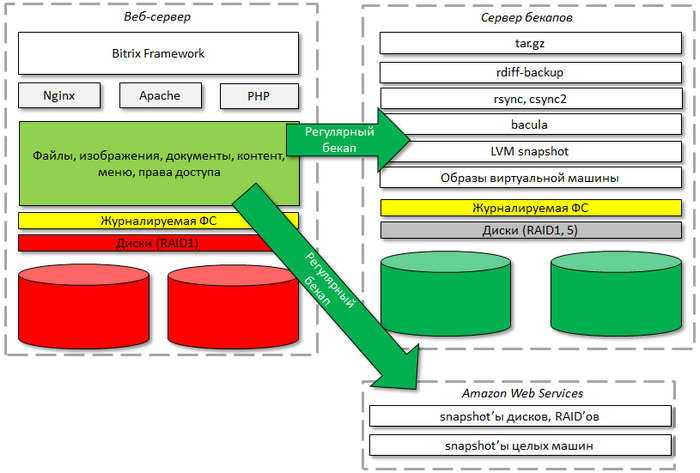

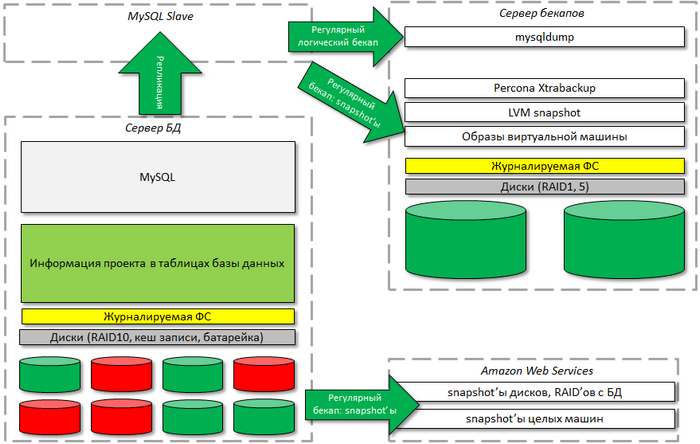

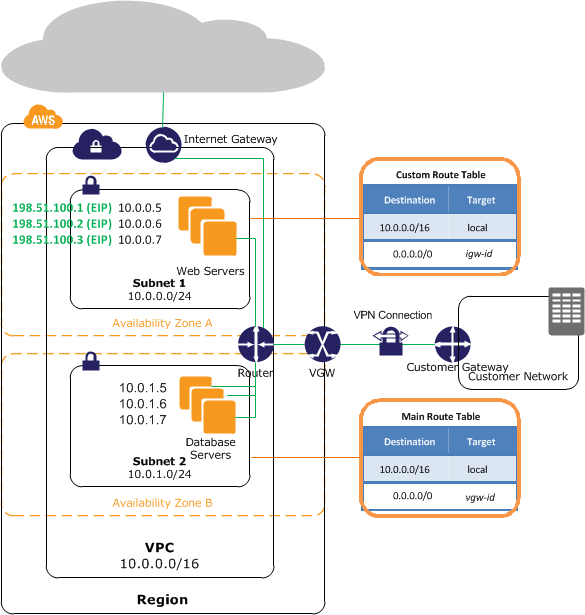

Возможно вам ещё понадобится "картинка" того, как вы будете размещать всё на серверах: Диаграмма развёртывания Deployment Diagram.

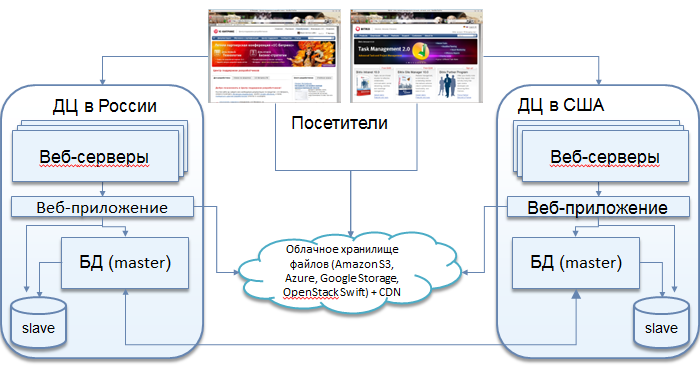

|

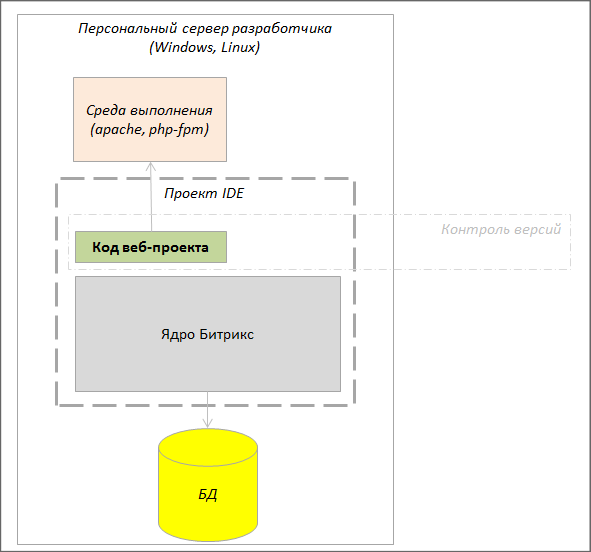

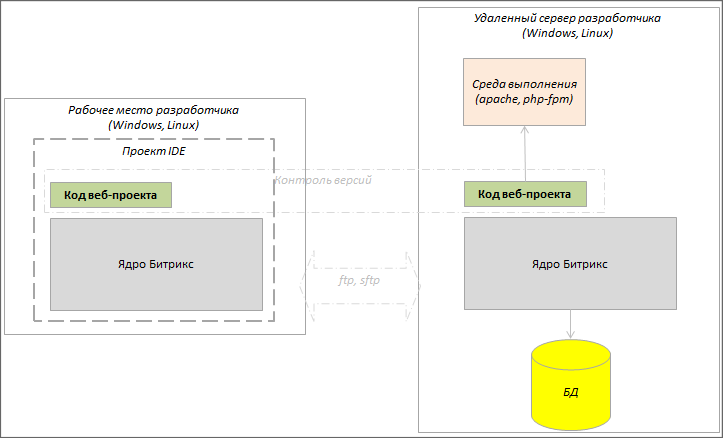

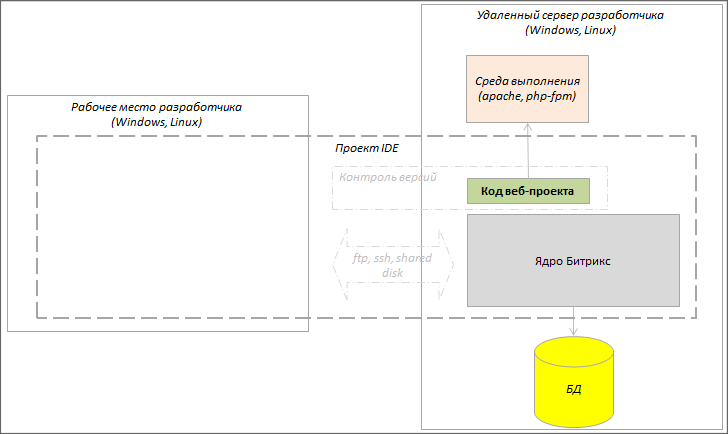

Пример диаграммы развёртывания

|

|---|

|

Возможна ситуация, когда требование озвучено, но не понятно ни клиенту, ни исполнителю. Это не страшно. Его надо зафиксировать не описывая. Впоследствии к нему можно вернуться.

Работа по сбору, формализации и структурирования требований не требует каких-то сложных и дорогих программных инструментов. Всё можно выполнять в обычном Excel.

Риски

Основные риски при сборе и анализе требований:

- Риск непонимания задачи, приводящий к переусложению системы. Нужно стремиться к простоте, использовать только нужное.

- Риск "невовлечённости" Клиента. Непонимание клиентом необходимости сбора и анализа требований приводит к провалу проекта. Клиенту может быть выгодно не иметь формализованного и согласованного списка требований. В этом случае он может "давить" на исполнителя, требуя выполнения работ, ранее не предусмотренных.

Иногда проблема возникает при недобросовестности, либо некомпетентности менеджера клиента, ведущего проект. Решение: требовать от клиента адекватного и добросовестного сотрудника.

- Риск формализации, когда слишком много времени и сил уходит на полную формализацию требований.

Критерии завершённости этапа

Сбор требований - сложный этап, который крайне сложно завершить в один заход. Как правило, Клиент не может сразу высказать все свои "хотелки". Это процесс долгий в силу того, что осознание потребностей приходит в результате постоянного контакта клиента с исполнителем, в результате итерационной реализации уже сформулированных заданий.

Переход к этапу проектирования можно выполнять после получения некоторых документов из перечисленного выше списка, достаточных для осознанного начала работ по проектированию. Риск возникновения каких-то не выявленных требований, незадекларированных сущностей при этом существенно снижается.

Прототип

На этапе сбора требований стало примерно понятно чего хочет клиент. Следующий шаг: создание прототипа.

Для чего делается прототипирование? Нужно проверить идею. Этап необходимый, так как позволяет оценить возможные риски, показать границы возможностей реализуемой идеи, выявить возможные сложности в реализации.

Примеры задач, где требуется создание прототипов.

- В магазине планируется 1 000 000 ценовых предложений, проект должен работать. Можно делать проект, заносить данные, но потом может выясниться, что система не сможет держать такую нагрузку.

Заливается 1 000 000 ценовых предложений на один сервер и проверяется как работает административная часть, как работает публичка, выбирается способ хранения данных (в случае Bitrix Framework: инфоблоки, инфоблоки 2.0 с индексами или Highloadblock), выбирается База данных и так далее.

- Внедрение какой-то сторонней системы в уже существующую. Например, Sphinx в Bitrix Framework. Необходимо изучить детали обоих систем, которые могут вызвать проблемы при взаимодействии. И проверять их.

- Раздача с сайта в 100 потоков 100 фильмов. И сделать это на одном сервере. Поднимается сервер и запускается аналогичная нагрузка. Оказалось, что выдерживает только 10 потоков.

- Использование какой-то библиотеки. Например, архивирование файлов: сжать файл, зашифровать, положить на удалённый сервер. В результате обнаружены ошибки в самом PHP, утечки памяти в библиотеке, незаметные в обычной жизни. На больших нагрузках это приведёт к неблагоприятным последствиям.

Для создания прототипа нужен опытный программист, способный увидеть технологические риски реализации конкретной задачи. Хотя прототип принесет немалую пользу и для начинающей команды: прежде всего убережёт от ошибок, связанных с отсутствием опыта работы с той или иной технологической платформой.

Прототип надо обязательно проверять на высокие нагрузки.

На работу с прототипом уходит не более двух-трёх дней и в случае положительного отзыва можно приступать к работе. В противном случае нужно предложить клиенту альтернативные варианты решения его задачи.

Архитектура проектов

Архитектура проекта

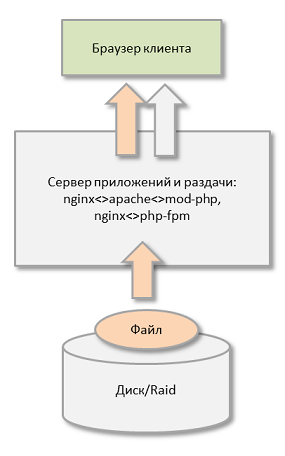

Самый простой в реализации пример архитектуры - это двухуровневая конфигурация веб сервера. Однако она применима только к несложным и ненагруженным (по нынешним меркам) проектам.

Для сложных и высоконагруженных проектов одной двухуровневой схемой не обойтись, нужен отдельный этап в разработке проекта: проектирование архитектуры.

Что бывает если нет архитектурного проектирования? Программисты начинают писать код на своё усмотрение, часто даже не согласовывая друг с другом. Если в компании слабая техническая вертикаль, не контролируют работу программистов ни технический директор, ни ведущий разработчик, то получается усложнённый код, так как у программистов нередко встречается желание "прокачаться" за счёт компании.

Если чёткого проектирования нет, а программисты слабо знакомы с предметной областью (а чаще вообще не знакомы), то часто выясняется, что сделано не совсем то или совсем не то. Требуется переделка, которая требует времени и может рождать дополнительные баги. Такой цикл может повторяться несколько раз, пока не подойдёт срок сдачи проекта. Как правило именно в этот момент до всех разработчиков доходит что нужно было на самом деле сделать, но времени уже нет.

Исполнитель пытается сдать то, что сделано, что непонятно как работает. Иногда это удаётся. Но если и удалось, то при попытке что-то поменять всё "рассыпается".

Что необходимо учитывать при архитектурном проектировании

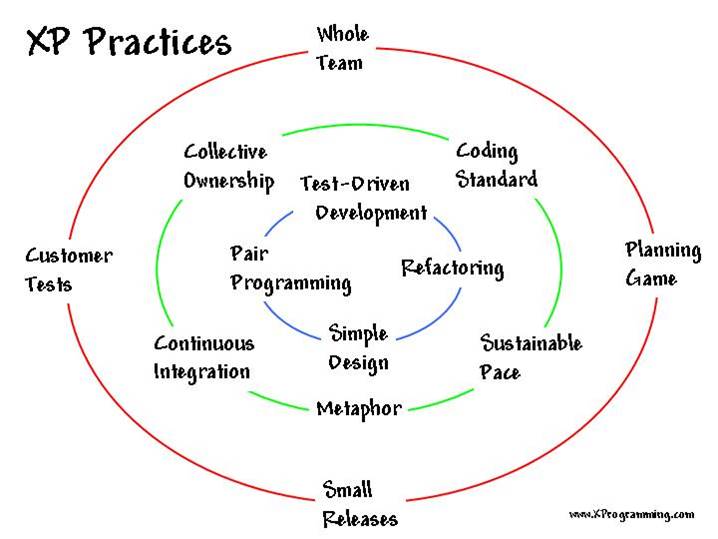

- TDD не применимо в разработке сайтов. Слишком сложно и слишком трудоёмко. Вёрстка, например, вообще не поддаётся автоматическому тестированию. Но этот метод может принести немалую пользу при разработке кастомных модулей и библиотек для сайта.

- ООП - требует подготовленных специалистов. Есть мнение, что ООП-программист - это вообще программист особого типа, им надо родиться. Если нет соответствующего опыта, то создавать проект с активным использованием ООП не рекомендуется, так как будет создан сильносвязанный и слабоуправляемый объектный "зоопарк".

- Использование фреймворков и библиотек, хотя и является оптимальным вариантом для большинства проектов, тоже представляет собой определённый риск при недостаточной подготовке команды и при отсутствии технического контроля со стороны ведущего разработчика.

Бесплатные фреймворки не гарантируют преемственности своих разработок. Разработчики могут просто начать вести новую ветку, приостановив поддержку старой, а для клиента это означает либо возрастание риска уязвимости (если оставаться на старой ветке), либо большие вложения (если переводить работу проекта на новую ветку фреймворка).

Материалы по теме

- Доклады на конференции FailOver Conference Украина

- Разработка сложного высоконагруженного проекта без SQL

- Контейнерная виртуализация для растущих проектов

Виды архитектур

Самые распространённые виды архитектур

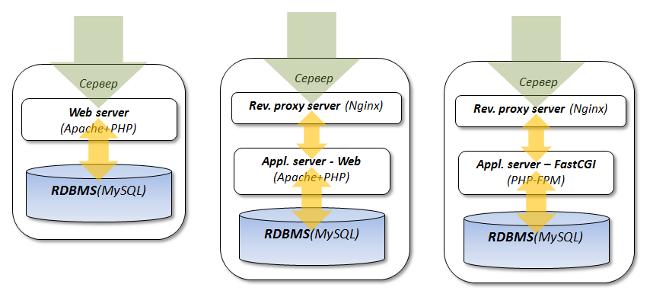

PHP-FPM + nginx

Наиболее простым и логичным решением по изменению архитектуры проекта являются следующие этапы "эволюции":

Переход к последней схеме позволяет в будущем проще и легче масштабировать проект и достичь более высокой производительности.

PHP-FPM – более эффективное решение:

- Исключен лишний веб-сервер.

- Меньший расход памяти [ds]форками[/ds][di]

Форк (fork с англ. — «развилка, вилка») или ответвление — использование кода программного проекта в качестве старта для другого, при этом основной проект может как продолжать существование, так и прекратить его.

Подробнее...[/di]. - Меньшее использование CPU и системных вызовов.

- Связка nginx – Apache использует TCP/IP, что ведет к накладным расходам.

- Связка nginx – PHP-FPM использует Unix domain socket, что быстрее.

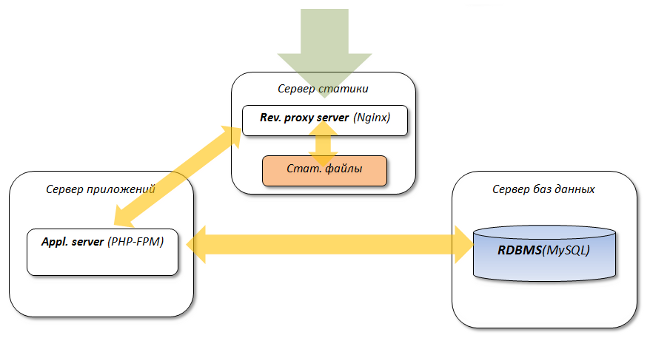

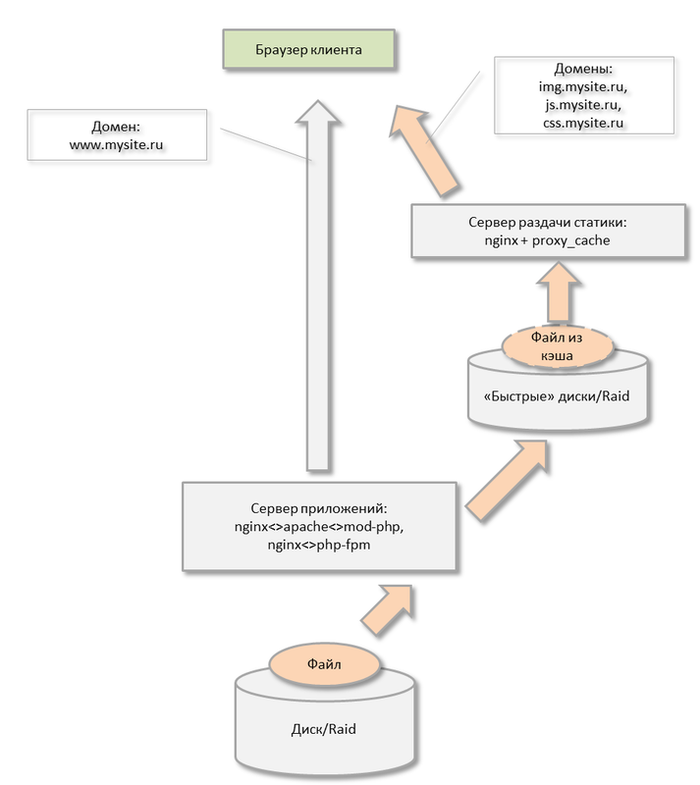

Разнесение приложений

Дальнейшим логическим развитием схемы является разнесение всех "приложений" на отдельные серверы:

Это позволяет значительно поднять общую производительность системы.

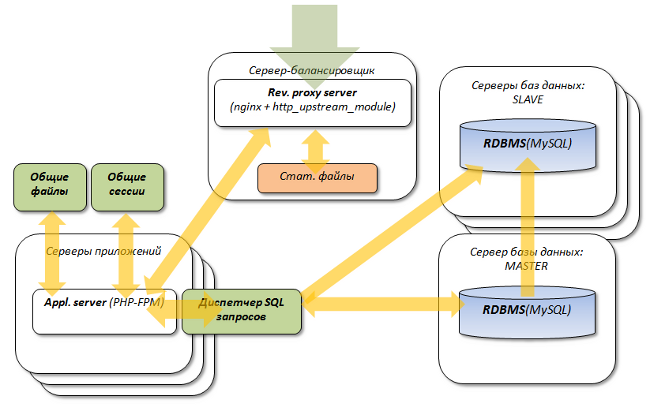

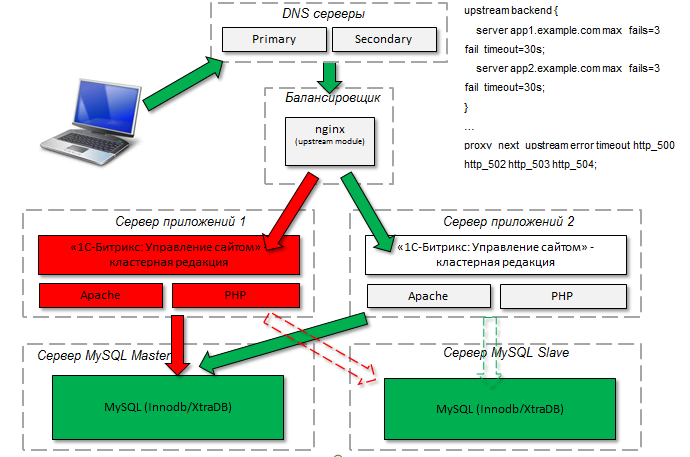

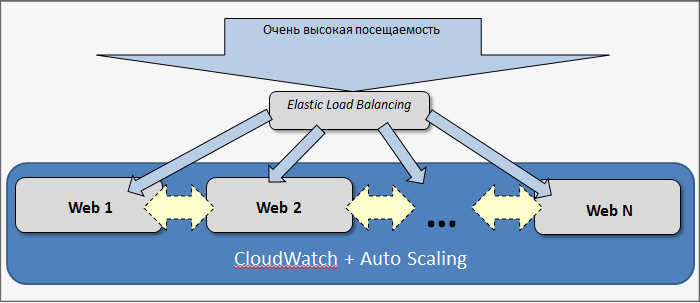

Кластеризация

След этап развития архитектуры проекта:

- Масштабирование серверов приложений;

- Master-Slave репликация базы данных с масштабированием slave-серверов;

- Балансировка нагрузки.

Интернет-магазины, высокие нагрузки

Общие сведения

Достаточно сложной категорией веб-проектов являются интернет-магазины. Для разработки магазина вам необходимо разбираться в следующих ключевых сущностях Bitrix Framework, используемых при его проектировании:

- модуле Информационные блоки;

- модуле Интернет-магазин;

- модуле Торговый каталог;

- модуле Валюты;

- вопросах авторизации.

Бывают такие ситуации, когда интернет-магазин (например, магазин некоторых услуг) может обойтись без модуля Торговый каталог. Поэтому перед началом разработки необходимо сразу определиться нужен ли вам данный модуль.

Если в магазине представлены каталоги товаров, то модуль Торговый каталог должен быть изучен очень тщательно. Прежде всего вам необходимо спроектировать ценообразование: определиться какие типы цен будут использоваться и в каких валютах. Также необходимо заранее решить какой курс валют будет использоваться, как он будет браться и обновляться, как вы будете его округлять (если делать будете это сами). При проектировании структуры каталога товаров следует заранее продумать будут ли использоваться у вас торговые предложения, наборы и комплекты. Кроме того, модуль Торговый каталог позволяет настроить гибкие системы скидок. Даже, если возникнет ситуация, что вам требуются скидки, которых нет в Bitrix Framework, то разрешить ее можно с помощью API Bitrix Framework, написав собственные обработчики.

Модуль Интернет-магазин позволяет сделать:

- Корзину. Она позволяет изменять свойства ее позиций, при этом цена изменяется динамически. При разработке корзины необходимо понимать, что корзина - это отдельная сущность. То, что находится в корзине, это уже не элементы каталога, это уже записи корзины.

- Мастер заказа. Необходимо понимать как работать с типами плательщиков, как интегрировать платежные системы и работать со свойствами заказа. Кроме того, следует предусмотреть возможность быстрого заказа.

- Персональный раздел. Когда клиент сделал заказ, то он должен видеть подробную информацию по своему заказу, список всех заказов, кнопку Повторить заказ, список подписок на товары и т.п. В зависимости от структуры вашего магазина, возможно, необходимо выводить клиенту список оплат, информацию по его лицевому счету (при наличии), пластиковым карточкам.

- Административную часть по обработке заказов. Необходимо спроектировать статусы заказа, продумать работу менеджеров магазина. Полезно также создавать и использовать кастомизированные формы административной части магазина.

Если ожидается, что проект будет большим, то к нагрузкам необходимо готовиться сразу. На этапе разработки следует выполнять аудит кода и оптимально использовать API Bitrix Framework, необходимо смотреть, чтобы не делались лишние запросы к базе. Кроме того, следует тщательно проектировать модели данных. Таким образом, следует использовать инфоблоки 2.0, в которых можно добавлять кастомные индексы.

Следует аккуратно работать с кешем: нельзя все кешировать. Проверяйте страницы так, чтобы они без кеша работали быстро, только потом включайте кеш, а не наоборот.

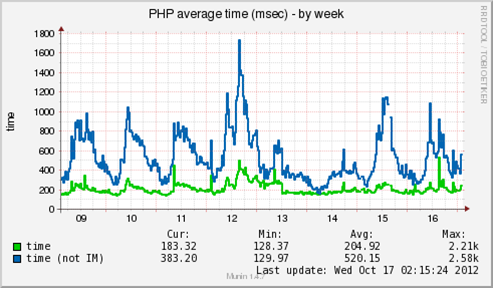

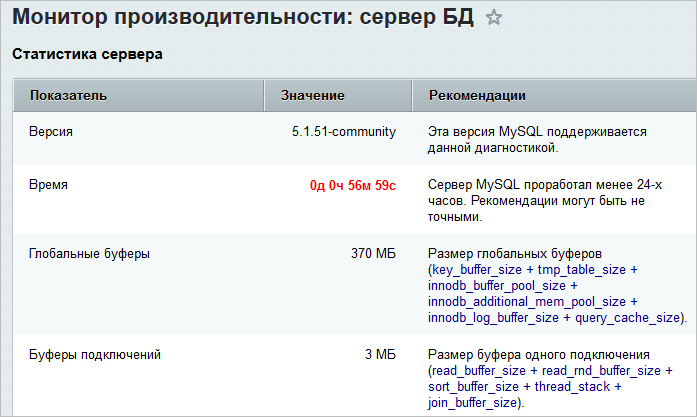

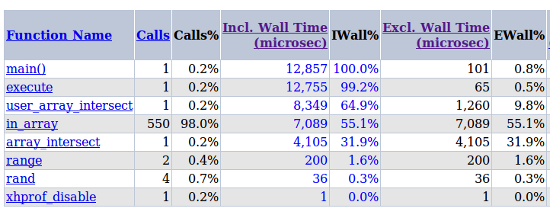

Что касается конфигурации, то настройте прекомпилятор PHP и анализируйте, что в него попадает. Проверьте в мониторе производительности, чтобы были включены все требуемые настройки PHP. Помимо этого, следует вести контроль версий и логи. Поскольку смотреть запросы - это задача программиста, то необходимо научиться понимать состояние базы данных. При работе используйте разного рода отладчики, Xdebug, XHPprof. Кроме того, рекомендуется использовать PHP-FPM для крупных проектов, потому что расходуется меньше памяти, выполняется меньше tcp/ip соединений.

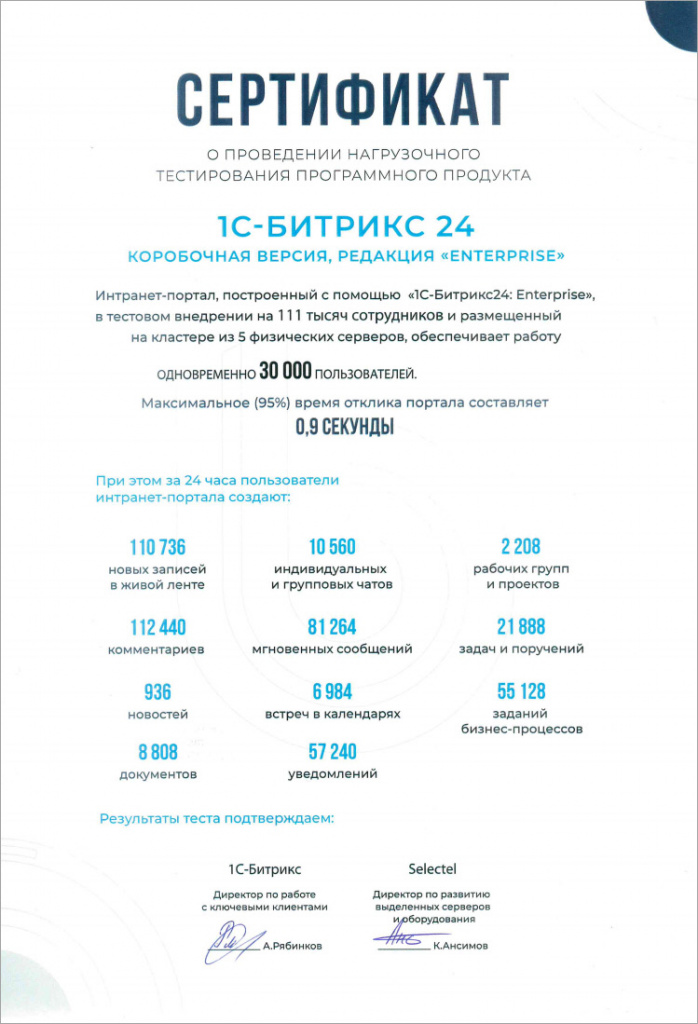

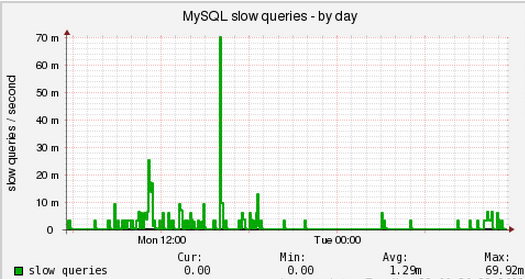

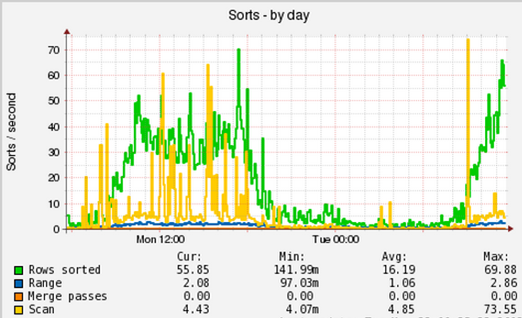

Высокие нагрузки

Допустим, что магазин уже разработан и запущен. Рассмотрим теперь простую и эффективную стратегию достижения и поддержки высокого уровня качества обслуживания посетителей интернет-магазина.

Фиксация обращений в логах

Для веб-проектов с посещаемостью в единицы миллионов хитов в сутки нужно настроить логирование всех обращений клиентов как к страницам, так и ресурсам. Важно понимать, что система может сохранять информацию о каждом обращении клиента и включить эту возможность очень просто (это штатное средство). Если интернет-магазин развернут на веб-кластере, то несложно настроить удаленное логирование на выделенный для этих целей сервер с использованием, например, syslog-ng. Логирование всех запросов клиентов незначительно (всего на несколько процентов) снижает производительность конфигурации, однако вы сохраняете полную информацию и контроль над качеством обслуживания клиентов. Практически все случаи ошибок и зависаний интернет-магазина фиксируются, доступны для дальнейшего анализа и корректировки процесса разработки и системного администрирования. Если логирование не настроено, то можно сказать, что вы не контролируете ситуацию.

Прежде всего нужно модифицировать стандартный формат логов NGINX, Apache, PHP-FPM и добавить туда описанные ниже ключевые показатели производительности. Кроме стандартных данных (таких как URL запроса, код ответа и т.п.), важно фиксировать по каждому хиту следующие данные:

- Время выполнения запроса: для NGINX это "$request_time", для Apache - "%D", для PHP-FPM - "%{mili}d". Кроме того, при двухуровневой конфигурации NGINX+Apache или NGINX+PHP-FPM полезно зафиксировать в логе NGINX также "$upstream_response_time".

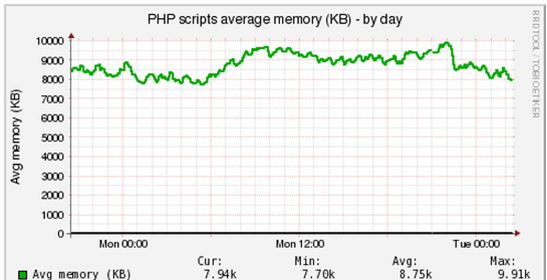

- Пиковое использование памяти при обработке запроса. Если вы используете PHP-FPM, полезно сохранить в логе "%{bytes}M".

- Код HTTP ответа. Обычно код HTTP ответа сохраняется в логах по умолчанию. Важно сохранять эту информацию, т.к. ошибки в обслуживании клиентов, как правило, имеют код ответа 40х или 50х.

- Отдельные логи производительности и настройки логов. Иногда удобно создавать отдельные логи, сохраняющие информацию о времени отработки скрипта и пиковом использовании памяти. Можно использовать такие опции:

- для nginx:

log_format main '$remote_addr - $remote_user [$time_local] "$host" "$request" ' '$status $body_bytes_sent "$http_referer" ' '"$http_user_agent" "$http_x_forwarded_for" -> $upstream_response_time';

- для apache:

LogFormat "%t \"%r\" %>s %b child:%P time-> %D" timing

- для php-fpm:

access.format = "%R # %{HTTP_HOST}e # %{HTTP_USER_AGENT}e # %t # %m # %r # %Q%q # %s # %f # %{mili}d # %{kilo}M # %{user}C+%{system}C"

- для nginx:

Анализ логов

Процесс фиксации информации об обращении клиентов в логах организован, все ошибки попали в лог. Теперь необходимо научиться их трактовать и инициировать устранение причин их появления.

Для начала рассмотрим самые распространенные типы ошибок:

- В случае ошибок в коде, прекомпиляторе (Segmentation Fault) или в операционной системе как правило отдается статус 500 (Internal Server Error). В этом случае посетителю показывается страница с сообщением о регламентных работах, либо (если не настроено) техническое сообщение об ошибке.

- Во время перегрузки Apache или PHP-FPM в двухуровневой конфигурации (долгие запросы к БД либо в коде идет обращение к внешнему сокету, либо число процессов Apache/PHP-FPM не соответствует реальной нагрузке) front-end (NGINX) зафиксирует в своих логах превышенное время отдачи страницы back-end'ом или ошибки 502 Bad Gateway, 504 Gateway Timeout. В этом случае, если не используется балансировщик нагрузки, посетителю, как правило, показывается страница о регламентных работах. При использовании балансировщика (например, upstream в NGINX) время отдачи страницы клиенту просто увеличится (что также будет зафиксировано в логах).

- При превышении скриптом PHP памяти в лог попадет ошибка 500 (Internal Server Error).

Теперь на примерах проанализируем, что происходило с обслуживаем клиентов магазина за сутки:

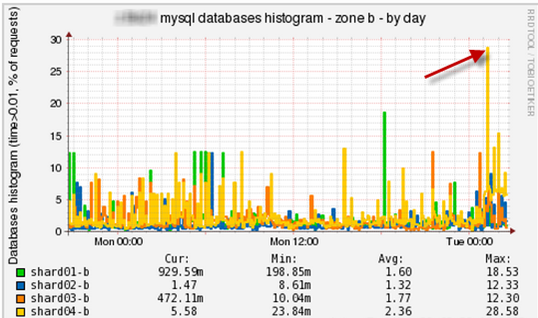

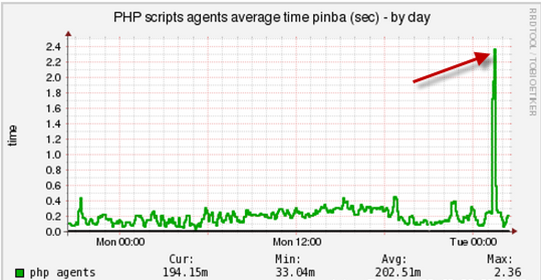

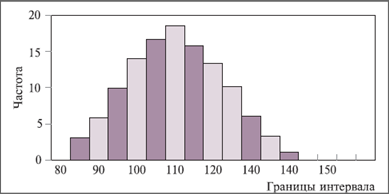

- Допустим, имеется следующая гистограмма HTTP-ответов на front-end'е и back-end'е:

Total hits: 265532 200 : 264654, 99.67% 207 : 34, 0.01% 302 : 830, 0.31% 401 : 7, 0.00% 403 : 1, 0.00% 404 : 1, 0.00% 500 : 16, 0.01%

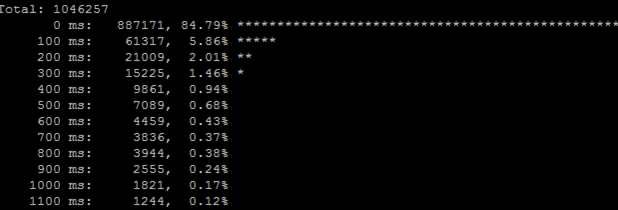

Мы видим, что более 99% хитов были успешны (код 200), однако было 16 ошибок, с которыми нужно разбираться разработчикам (в логах PHP) и искать способы их устранения. - Гистограмма времени выполнения страницы на front-end'е и back-end'е следующая:

Total: 386664 0 ms: 276203, 71.43% 100 ms: 81466, 21.07% 200 ms: 13155, 3.40% 300 ms: 4282, 1.11% 400 ms: 2183, 0.56% 500 ms: 1373, 0.36% 600 ms: 968, 0.25% 700 ms: 721, 0.19% 800 ms: 586, 0.15% 900 ms: 470, 0.12% 1000 ms: 398, 0.10%

Видим, что подавляющее число запросов клиентов было обслужено со временем менее 500 ms. Однако с 398 хитами более секунды нужно основательно разбираться. Страницы или сервисы могут отрабатывать единицы секунд в следующих случаях:- Не используется кеширование результатов обращений в базу данных либо само обращение в базу данных не оптимизировано.

- Выполняется тяжелый аналитический запрос, например, число заказов такого-то товара за такой-то период. В этом случае ошибки нет, такой запрос лучше исключить из анализа.

- В коде скрипта идет обращение к внешнему ресурсу, который завис (RSS-лента, внешняя авторизация и т.п.). Общее правило в таком случае: обращаться к подобным «рискованным» внешним ресурсам либо в отдельном потоке (cron), либо асинхронно из браузера клиента по ajax, кешируя результаты ответа. Таким образом, даже если внешний ресурс недоступен, то веб-страница должна отдаться посетителю быстро, менее чем за секунду (и аккуратно догрузить части страницы).

- Гистограмма потребления скриптами памяти на back-end'е - PHP-FPM:

Total hits: 265562 0 KB: 25, 0.01% 4000 KB: 16, 0.01% 6000 KB: 67094, 25.26% 7000 KB: 123746, 46.60% 8000 KB: 61102, 23.01% 9000 KB: 3453, 1.30% 10000 KB: 1263, 0.48% 11000 KB: 890, 0.34% 12000 KB: 826, 0.31% 13000 KB: 917, 0.35% 14000 KB: 1129, 0.43% 15000 KB: 1125, 0.42% 16000 KB: 936, 0.35% 17000 KB: 798, 0.30% 18000 KB: 631, 0.24%

Видно, что большинство скриптов веб-решения потребляют 6-8 МБ памяти, что немного. Однако, нередко при разработке «в сжатые сроки» получаются скрипты, которые потребляют 500МБ или единицы гигабайт памяти, что вызывает зависание сервера и общую дестабилизацию системы. Важно анализировать данную гистограмму и ставить ТЗ разработчикам на оптимизацию объема потребляемой страницами памяти в пределах, допустим 64 МБ. Таким образом, постепенно, система будет потреблять стабильно предсказуемый объем памяти и вы будете уверены, что она внезапно не впадет «в спячку» на несколько десятков минут.

Кроме того, используя для логов соответствующие bash/awk-скрипты, полезно также получить статистику по максимальным значениям: топу самых медленных страниц в сутки и топу самых затратных по памяти страниц в сутки. А также если вы используете PHP-FPM, то можете получить более подробную информацию о зависания PHP-скриптов с помощью специальной возможности логирования скриптов, которые выполняются более N секунд.

Таким образом, настроив сбор ключевой статистики по хитам клиентов интернет-магазина, нужно создать постоянно действующий бизнес-процесс по доработке и оптимизации веб-решения: раз в сутки статистика должна рассылаться всем участникам технологического процесса и при превышении заранее оговоренных показателей автоматически должен начинаться поиск, устранение ошибок и/или оптимизация кода веб-проекта. В качестве целевых критериев можно взять:

- число показов клиентам страницы о регламентных работах (т.е. число ошибок 50х): 0;

- число хитов в публичной части, обслуженных быстрее 0.5 секунды: 100%;

- число хитов в административном разделе (где могут выполняться «тяжелые» аналитические выборки): быстрее 10 секунд - 100%, среднее время хита в админке - 0.5 сек;

- максимальный объем памяти, использованный скриптом: менее 128МБ, средний объем - 32МБ.

Программная архитектура высоконагруженных веб-систем

Традиционное устройство веб-продуктов

Стандартное веб приложение работает на одном сервере: собственно веб-сервер, кеширование, база данных приложения. Достаточно часто ресурсов сервера перестаёт хватать и приходится переходить на новый тарифный план или производить апгрейд сервера. Это первый шаг в долгом процессе - вертикальное масштабирование, когда добавляются ресурсы сервера. Рано или поздно происходит упор в ограничение возможностей либо хостинга, либо "железа".

Следующий шаг - разделение приложения, когда приложение делится на составные части (web, БД, кеш) и эти части работают на разных серверах. С точки зрения производительности большинству проектов бывает достаточно такого разделения. Однако такое деление не решает задачу надёжности и отказоустойчивости. Каждый узел не зарезервирован и в случае выхода из строя любого из них перестаёт работать весь проект в целом.

Следующий логический шаг - научиться масштабировать дальше. Научиться представлять любой узел системы в виде кластера серверов, которые будут взаимозаменяемы, и в случае аварии проект продолжит работу. На этом этапе возникают сложности: просто так добавить несколько серверов под БД, несколько серверов под web уже становится сложно, потому что приходится значительно переписывать, перерабатывать логику веб-приложения.

Основные задачи, которые решает веб-кластер - это задача производительности и задача отказоустойчивости:

- Обеспечение высокой доступности сервиса, так называемые HA (High Availability или Failover) кластеры.

- Масштабирование веб-проекта в условиях возрастающей нагрузки (HP - High Performance кластеры).

- Балансирование нагрузки, трафика, данных между несколькими серверами.

- Создание целостной резервной копии данных для MySQL.

Как представить своё приложение в виде кластера

Введение

Когда переходы на новый тарифный план или апгрейд "железа" сервера перестают решать проблемы производительности (либо становятся чрезмерно дорогими), то направление развития приложения одно: переход на кластерные технологии.

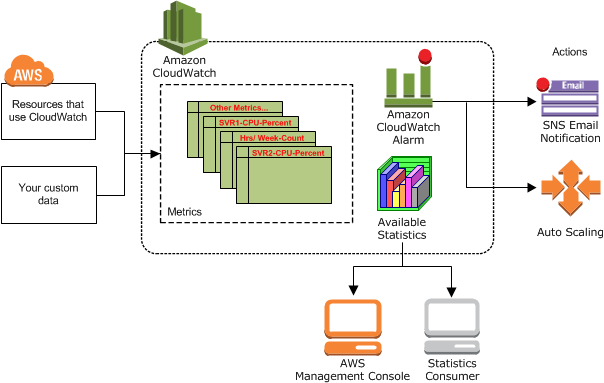

Решать задачу представления приложения в виде кластера можно с помощью следующих технологий, которые позволяют масштабировать базу данных, кеш, web и представить каждую из составляющих в виде группы взаимозаменяемых серверов:

- Вертикальный шардинг (вынесение модулей на отдельные серверы MySQL).

- Репликация MySQL и балансирование нагрузки между серверами.

- Распределенный кеш данных (memcached).

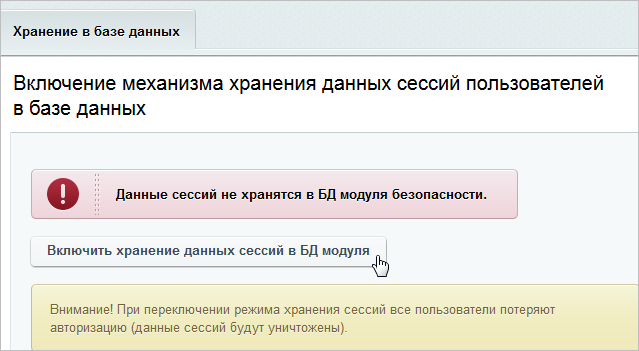

- Непрерывность сессий между веб-серверами (хранение сессий в базе данных).

- Кластеризация веб-сервера:

- Синхронизация файлов.

- Балансирование нагрузки между серверами.

С проектной точки зрения создание такого приложения в виде веб-кластера нужно выполнять в два шага:

- разделение веб-сервера и базы на два разных сервера (это не кластер как таковой),

- построение собственно кластера.

Разделение веб-сервера и базы на два разных сервера

На этом этапе приложение делится на составные части (web, БД, кеш), и эти части работают на разных серверах.

Этот этап не сложен в проектировании, и его выполнения с точки зрения производительности большинству проектов бывает вполне достаточно. Однако такое деление не решает задачу надёжности и отказоустойчивости. Каждый узел не зарезервирован, и в случае выхода из строя любого из них перестаёт работать весь проект в целом.

Построение кластера

Для реализации этого этапа необходимо решить следующие задачи:

- Репликация и балансировка нагрузки MySQL.

- Масштабирование веб-сервера.

- Задачи синхронизации файлов и авторизации пользователей.

- Масштабирование кэша.

Репликация и балансировка нагрузки MySQL

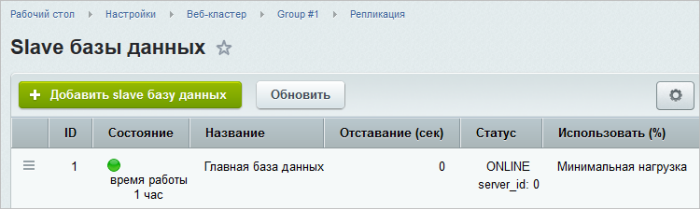

Самое простое решение - репликация, возможность которой предоставляет любая современная база данных. Чаще всего используется MySQL, так как она достаточно проста, понятна, хорошо документирована. Средствами самой базы можно организовать репликацию, добавить некоторое количество slave-серверов, которые будут получать данные с master'а, и логично вынести select и запросы на чтение на эти slave.

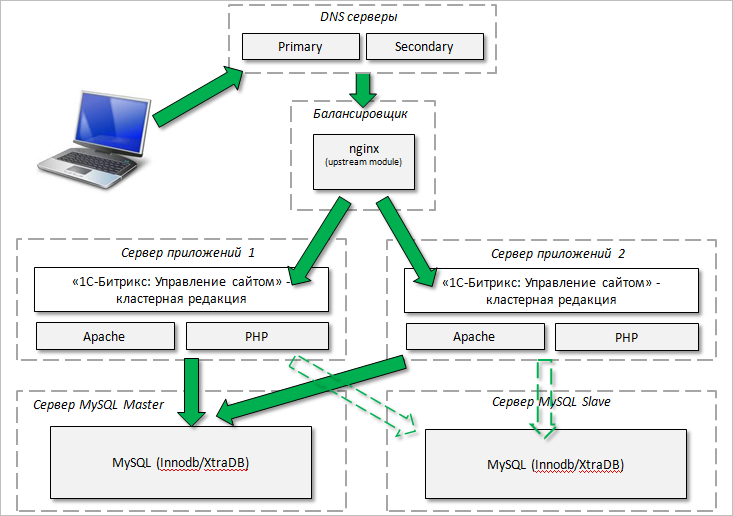

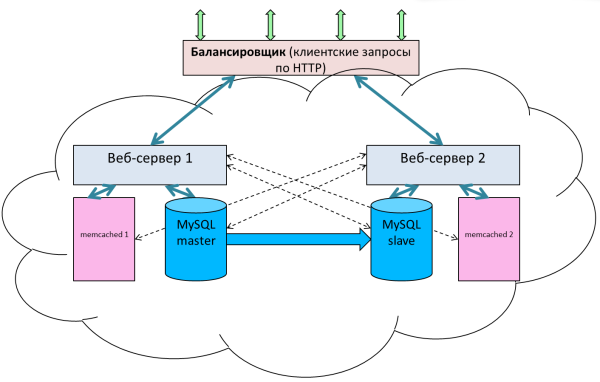

Схема типового веб-приложения с реплицированной базой:

Все запросы на запись отправляются на master, все запросы на чтение отправляются на slave. Это самый простой способ масштабирования.

Если этот механизм будет реализован средствами Базы данных, то на долю самого приложения остаётся диспетчеризация всех этих запросов и распределение их между серверами. Делать это лучше именно на уровне ядра приложения, потому что:

- Обеспечивается гибкая балансировка нагрузки SQL.

Очень часто необходимо произвести чтение с данных, которые были только что изменены. Например, первым запросом добавили пользователя, а вторым - запросили список пользователей. Если запрос на запись отправляется на мастер, а запрос на чтение списка пользователей отправляется на slave, то возможна ситуация, когда slave отстают от master'а (типовая ситуация) и в ответ приходят устаревшие данные. Для списка пользователей такое положение, возможно, терпимо, но если речь идёт о заказах интернет-магазина или банковских транзакциях, то неправильные данные - это критично. Именно приложение должно определять, какие select'ы нужно отправлять тоже на master для получения актуальных данных. Это означает чуть большую нагрузку на master, но зато это гарантирует получение корректных данных.

- Приложение проще администрировать.

- Обеспечивается дешевое и быстрое неограниченное масштабирование.

Приложение должно заниматься балансировкой нагрузки между slave'ми, условия которой задаются произвольным образом. В административном интерфейсе можно подключить любое количество серверов и для каждого из них задать свой вес. Возможны разные случаи, например, разные конфигурации серверов, и на тот, что помощнее, оптимально будет задать больше нагрузки. Если для этого сервера поставить больший вес, то ядро приложения будет отправлять на него больше запросов.

- Облегчается работа приложения во время выполнения бэкапа, что особо актуально для больших объёмов данных. Если на один из серверов задать вес, равный 0 (то есть не отправлять на него запросы вообще), то его можно использовать для снятия резервных копий. Это удобно в том плане, что не создаётся дополнительная нагрузка на "боевые" сервера, что в любом случае будет замедлять работу проекта.

- Не требуется доработка логики веб-приложения.

Задачи синхронизации файлов и авторизации пользователей

Не внося больших изменений в логику веб-приложения, можно добавить несколько веб-серверов, над ними поставить любой из доступных балансировщиков: от распределения по DNS и заканчивая специализированными решениями типа балансировщика Amazon'а, либо "железные" решения типа Cisco, или простейший отдельный сервер NGNIX, который распределит запросы по нескольким серверам.

Этими инструментами можно решить задачу балансировки, но нельзя решить задачи:

- Синхронизации контента между серверами. (Администратор или пользователь добавляет контент, например, картинку, и этот контент должен отобразится на всех серверах.)

- Синхронизации пользовательских сессий. Пользовательская сессия должна быть прозрачной для всех серверов веб-кластера. После авторизации на одном из серверов пользователь должен считаться авторизованным и для всех других серверов. И наоборот - окончание сессии на любом сервере должно означать ее окончание на всех серверах сразу.

Вопрос с сессиями решается достаточно просто. Они выносятся в отдельное централизованное хранилище. Либо в Базе данных, либо в мемкеше.

Вопрос с синхронизацией файлов в случае небольшого проекта достаточно прост. Можно подключить единое хранилище, например, через Network File System и работать с файловой системой со всех серверов. Удобно, но не быстро.

Другой вариант: хранить файлы на каждом сервере и использовать для синхронизации сторонние утилиты. Просто, но нет возможности синхронизировать данные моментально, всё равно будет временной промежуток недоступности файлов на каких-то серверах. С ростом объёма данных этот механизм будет работать всё менее надёжно и с замедлением.

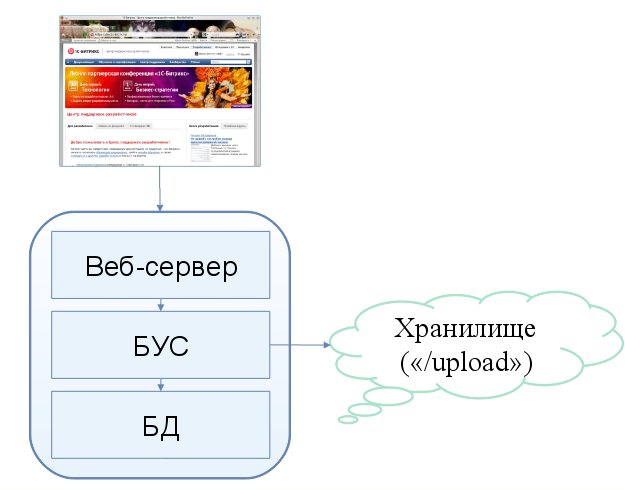

Оптимальным решением будет вынесение всего основного контента (чаще всего это документы, картинки, видео- и аудио-файлы) в какое-то отдельное централизованное хранилище. То есть полностью разделить логику кода и веб-приложение и не хранить эти данные на веб-сервере. Этим способом будет кардинально решена задача синхронизации.

Для реализации такого хранилища можно сформулировать несколько правил:

- Должно существовать API хранилища для прозрачной работы с файлами.

- Нужно разработать API в создаваемом приложении для разработчиков. Файл не хранится локально, значит, не подойдут стандартные функции для работы с ними, нельзя оперировать какими-то свойствами файлов (размер, изображение). Эти данные должны получаться при загрузке файла через какой-то (административный или пользовательский) интерфейс системы и сохраниться в служебной таблице.

- Необходимо избегать "диких", то есть загруженных в обход системы файлов (например, FTP). Такие файлы можно отлавливать через обработку 404-ой ошибки.

- Необходимо простое подключение хранилищ, желательно одной кнопкой в приложении.

- Нужно создать правила при работе с несколькими хранилищами.

- Нужно обеспечить прозрачность работы для всех модулей системы.

Для реализации можно использовать какой-то отдельный FTP сервер и выносить файлы туда. Но при этом не решается задача резервирования и надёжности. Для решения этих задач придётся применять другие методы, скажем, средства операционной системы, систем резервного копирования и других инструментов.

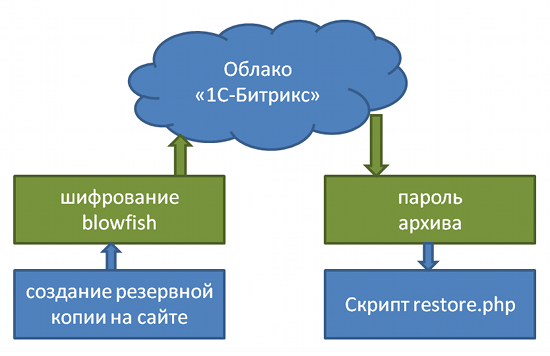

Заведомо надёжное хранилище - это облачное хранилище, которое в последнее время предоставляет всё большее число провайдеров. При этом оптимальным будет решение, когда на одном проекте одновременно можно хранить разные файлы в разных облачных хранилищах. Например, все файлы "весом" больше 100 Мб перемещать в Google Storage, а все видео - в Amazon S3.

Такое деление позволяет:

- прямо в ходе работы оценить удобство, скорость и стоимость работы каждого хранилища и подобрать оптимальные варианты размещения контента.

- избежать не очень комфортной ситуации vendor lock-in.

- прямо в ходе работы переезжать с одного хранилища на другое, не прерывая работу проекта.

Rest API для всех популярных языков есть у всех хранилищ, проектирование системы на облаках не вызывает затруднений у квалифицированного разработчика.

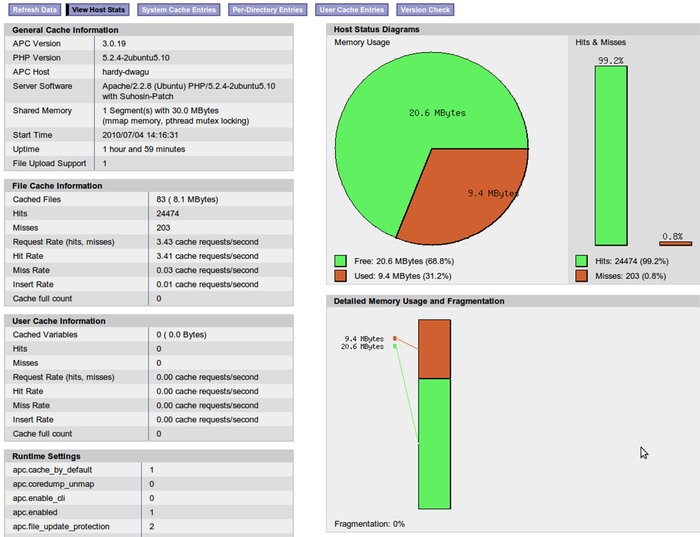

Распределенный кеш данных

Работа с кешем аналогична работе с БД: можно подключить группу кеш-серверов, масштабируя группу по мере необходимости. (На практике использование более одного сервера - ситуация крайне редкая, только в случае очень больших проектов.)

Основная задача, которая решается распределением кеша по группе серверов - это отказоустойчивость. Кеш можно распределять, как и в случае с БД, по весам, которые задаются в административной части приложения.

- Высокая эффективность - за счет централизованного использования кеша веб-приложением.

- Надежность - за счет устойчивости подсистемы кеширования к выходу из строя отдельных компонентов.

- Неограниченная масштабируемость - за счет добавления новых memcached-серверов.

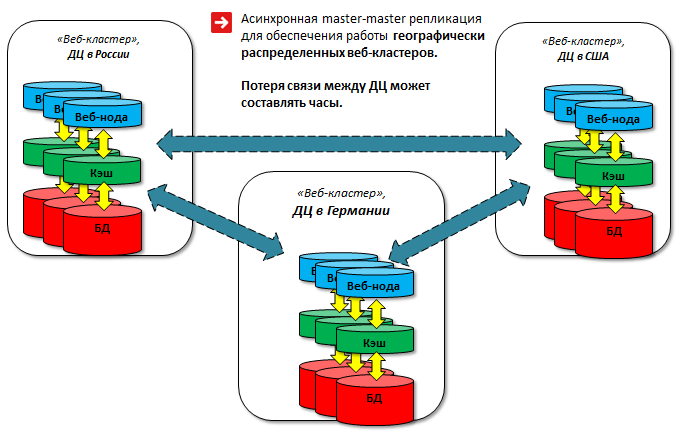

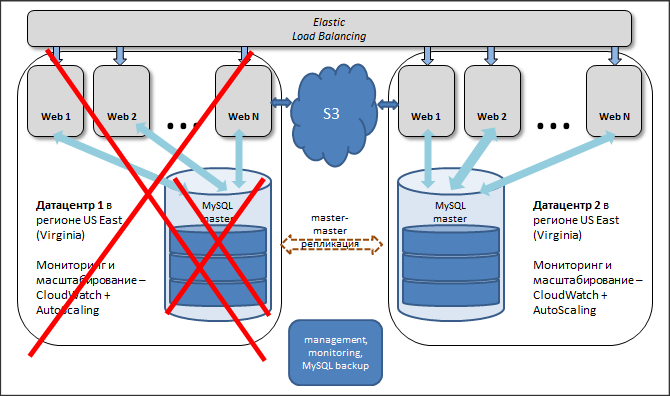

Гео-кластер

База данных, узкие места

Можно организовать распределение нагрузки на чтение между slave'ми. Но, так как все веб-сервера читают данные со всех серверов MySQL, то остаются высокие требования к связанности сети, пропускной способности, величине задержки между пакетами. В идеале все сервера должны находиться в одном дата-центре. Однако, если случится авария на уровне целого дата-центра, возникнет проблема. Такое возможно, более того, такое происходило.

Другая проблема - невозможность масштабирования между разными серверами, так как мы потеряем в скорости.

Третья проблема может возникнуть, если выйдет из строя master. В этом случае требуется заранее либо автоматизировать процедуру его восстановления, написать какие-то скрипты, которые будут превращать один из slave в master, либо оставить это администратору на ручной разбор ситуации. Правда, если авария произошла когда администратор недоступен, то проект может простаивать достаточно долго.

Необходимо резервировать сам дата-центр. По-хорошему, проект должен быть распределён географически по миру или, как минимум, по двум дата-центрам, чтобы можно было обезопасить проект даже от таких аварий.

Что можно сделать? Гео-кластер, хотя бы в упрощённом варианте. Правда, тут возникают повышенные требования к проектированию приложения.

Гео-кластер

Предлагаемая схема - весьма условная master-master репликация, так как не происходит одновременной записи в две базы. Однако в большинстве случаев задача резервирования решается полностью. Эта схема позволяет держать несколько master'ов, хотя и с рядом ограничений.

Создаются группы серверов в административном интерфейсе:

У каждой группы свой MySQL master (указан в dbconn.php). Мастеры MySQL объединены в кольцо (в минимальном варианте – 2 сервера).

Каждая группа клиентов работает с определённым сервером. Например, посетители из Европы должны попадать в европейский дата-центр и писать в master, который, находится там. Посетители из России должны попадать в российский дата-центр, и так далее. В случае аварии трафик переключается на другой дата-центр, и все посетители продолжают работать с "горячими" данными без каких-то отставаний и потерь.

Реализуется такая схема следующим образом: в самом MySQL есть возможность задать смещение для полей: auto_increment_increment и auto_increment_offset. Это обеспечивает поступление данных "стык в стык" и они не будут дублироваться. Базы в разных дата-центрах синхронны, при этом независимы друг от друга: потеря связности между дата-центрами может составлять часы, данные синхронизируются после восстановления. Таблицы БД должны иметь подобные ключи, чтобы данные не дублировались и не попадали одинаковые в разные дата-центры.

Пользователь и все сотрудники одной и той же компании работают в одном датацентре за счет управления балансировщиком. Этим исключаются сбои в подобной схеме работы master-master репликации. Сессии хранятся в базе, и объём этих данных достаточно большой. В результате были ошибки в получении данных из query кеша. Эти данные, так как пользователи направляются на определённые сервера, можно не реплицировать из-за большого трафика и возможных блокировок:

SET sql_log_bin = 0

или

replicate-wild-ignore-table = %.b_sec_session%

В результате достигнут один из приоритетов - постоянная доступность сервиса, его отказоустойчивость. Все ноды заменяемы и не зависят друг от друга, в случае аварии стартуем новые. Два дата-центра синхронизированы друг с другом и равноценно обслуживают клиентов. В случае аварии на уровне дата-центра или плановых работ с базой трафик прозрачно для клиентов переключается на рабочий дата-центр.

Вертикальный шардинг

Вертикальный шардинг - первое, что обычно делается при возникновении нехватки ресурсов. Реализация этого разделения БД не сложна и не требует серьёзного программирования, зато появляется возможность идеально подстроить сервер для работы с одной специфической таблицей, постараться уместить ее в память, возможно, дополнительно партиционировать ее и т.д.

Архитектура Базы данных

Схемы работы с БД

Работа напрямую через PHP-функции. Обеспечивает скорость разработки, гибкость, но вызывает сложность поддержки и неудобство использования. Подходит для простых проектов, не рекомендуется для больших и средних.

Работа через прослойку на основе паттерна TableModule. Работа с базой данных идёт через класс (объект), предоставляющий собой интерфейс доступа к таблице. Преимущество подхода в том, что работа с БД инкапсулируется в каком-то классе, сущности. Любые модификации идут через эту сущность. При этом упрощается развитие, поддержка и эксплуатация проекта. Недостаток: реализация сложнее, если проект разрабатывается без фреймворка, где это уже реализовано.

ORM для сложных проектов. На проектах со сложными предметными областями и сущностями иногда полезно использовать паттерны:

- ActiveRecord — объект представляет собой запись в таблице, позволяющую успешнее решать задачи большой и сложной предметной области со связями. Недостаток: большой объём кодирования, но можно использовать библиотеки.

- DataMapper — объекты не знают о БД ничего, есть только объекты и их свойства. Программисту легко реализовывать бизнес-логику в таких условиях, а за работу с БД отвечает слой DataMapper.

На этапе разработки архитектуры важно предусмотреть горизонтальное масштабирование базы данных. Позже это может быть сложно. О веб-кластере стоит задуматься уже на этапе прототипа, если проект большой и высоконагруженный. Оптимально использовать готовый фреймворк, чем самостоятельно решать вопросы:

- Репликация: решаемая и несложная задача.

- Кластеризация кода: сложнее всего кластеризовать сессии и кеш. Сессии можно хранить в базе данных или memcache.

- Нагрузка и распределение: возможно через NGINX или другим способом.

- Хранение и отдача статики. Использовать CDN?

- Авторизация.

- Шардинг: может потребоваться для очень больших проектов.

Что выбрать?

Для слабых и средних команд рекомендуется использовать фреймворк, с которым команда знакома лучше всего. Это убережет от множества проблем и рисков, сократит затраты на разработку проекта (за счет того, что фреймворк даёт готовую архитектуру).

Сильные команды с большим опытом могут решиться на разработку «с нуля», если это позволит клиент по срокам и финансированию.

NoSQL для архитектора веб-проекта

NoSQL и его возможности

В последнее время все больше говорят про NoSQL. Технологии этого семейства начинают активно использовать известные авторитетные компании, в том числе в высоконагруженных проектах с немалыми объемами данных. Чтобы понять, применима ли эта технология к создаваемому вами проекту, надо разобраться в ваших потребностях и понять, сможет ли она их удовлетворить.

В двух словах NoSQL - это необходимость выбора в рамках проекта двух из трех принципов работы с БД: согласованность данных (Consistency), доступность (Availability), устойчивость к разделению (Partition tolerance).

Причина такой необходимости - новые бизнес-задачи, которые возникли в последнее время:

- База должна быть всегда доступна для записи и чтения, и кейсы типа: сервер перезагружается, сеть упала - становятся критичными для бизнеса.

- Интенсивный рост объемов данных и ужесточение требований к их доступности, в том числе из-за бурного развития всемирной сети (в одной базе данные просто перестали помещаться).

- Клиентов становится много в разных точках мира, и нужно сохранить заказы как можно быстрее.

- Бурный рост веб-сервисов, появление мобильных устройств.

В техническом плане эти требования означают, что база должна:

- быть доступна всегда, нельзя потерять заказ клиента или его корзину, даже если пропала синхронизация между нодами базы данных.

- быть доступна везде (Европе и США), и, конечно, синхронизировать данные между копиями.

- неограниченно масштабироваться при увеличении объема данных.

- масштабироваться под нагрузку: на запись, на чтение.

При этом классические кластера БД не могут обеспечить эти возможности. Вот описания проблем, свойственных популярным БД:

- Oracle RAC - дорого и сложно, тяжеловесно, и непонятно, как раскидывать по разным материкам.

- MySQL cluster - быстрый мастер-мастер, но много подводных камней и ограничений вроде хранения данных только в памяти. Всё же достаточно удобен для некоторых кейсов.

- galera cluster for mysql - честный мастер-мастер, пиши куда хочешь (но должен знать, куда именно). Нет "устойчивости к разделению", может зависнуть при отсутствии кворума. Трудно восстанавливается при падении и тормозит при геораспределенном использовании, т.к. синхронно передает данные на все копии. Нет шардинга данных между мастерами.

Так вот, прошло не так много времени, как в начале нынешнего столетия появились NoSQL-продукты и стало возможным:

- писать на любой элемент кластера;

- размещать элементы кластера на разных материках и читать с локальных;

- выключать любую ноду кластера без угрозы для системы в целом

- добавлять ноды кластера по потребности, что позволяет масштабировать как запись, так и чтение.

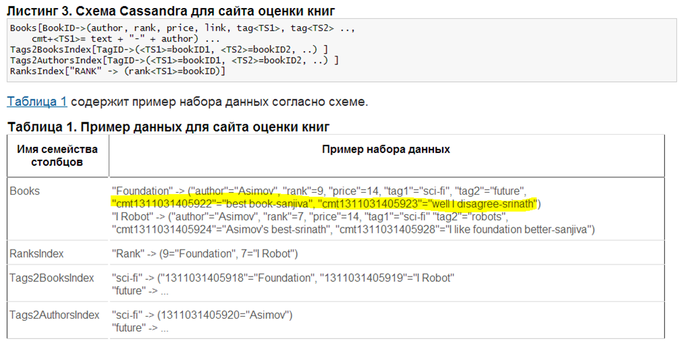

Пример того, как программисты реализуют требования бизнеса используя NoSQL. В строке с информацией о книге хранятся комментарии пользователей к ней. Что невозможно в рамках традиционной БД:

Ограничения NoSQL

Но и у NoSQL есть свои ограничения.

- NoSQL позволяет писать на любую ноду кластера, но по умолчанию читать приходится устаревшую неконсистентную информацию, так как информация распространяется с ограниченной скоростью. NoSQL-продукты предоставляют опцию чтения только что записанной информации, но за это придется платить увеличением времени ожидания.

- NoSQL позволяет разместить ноды кластера на разных материках, но так как информации нужно время, чтобы она разошлась по континентам, то приложение должно уметь это обработать.

- NoSQL позволяет выключать любую ноду кластера, но устойчивость к разделению кластера реализована за счет технологий, похожих на версионность. Следовательно, периодически нужно будет запускать поиск рассогласований типа Anti-entropy using Merkle trees.

- NoSQL позволяет добавлять ноды кластера по необходимости, но конфигурировать остальные ноды все-таки придется, и иногда это совсем не просто сделать.

Это общие для продуктов NoSQL ограничения. Но есть нюансы и в использовании конкретных реализаций. Рассмотрим их на примере Amazon DynamoDB (очень похожий на Apache Cassandra.)

Ограничения Amazon DynamoDB:

- Мало типов данных: число, строка, бинарные данные. Нет DATETIME (их можно эмулировать таймстампом).

- Ограничения по индексам. Индексы нужно указать сразу, их должно быть не более 5 на таблицу. Причем добавлять их в существующую таблицу нельзя, нужно ее удалять, пересоздавать и перезаливать туда данные.

- Можно хранить любой объем данных, но размер одной "строки таблицы" с именами и значениями "колонок" не должен превышать 64КБ. Правда число "колонок" не ограничивается. И на одной ноде кластера (c одним значением основного индекса hash key) при наличии дополнительных индексов нельзя хранить больше 10ГБ. (Термин "колонока" - условный. В NoSQL нередко понятия схемы данных просто нет, поэтому в каждой "строке таблицы" могут быть разные "колонки" или "атрибуты".)

- Запросы. Можно выбрать данные только по одному индексу. Есть еще основной (hash key) индекс, но диапазонные выборки делать по нему нельзя - только константные. Отсортировать можно только по одному индексу.

Нельзя использовать сложные WHERE, GROUP BY, не говоря уже о подзапросах: NoSQL-движки их просто эмулируют и могут выполнять очень медленно.

Можно выполнять более сложные выборки, но методом полного сканирования таблицы (table scan) и затем поэлементной фильтрации результатов на серверной стороне, что и долго и дорого.

- Транзакции: гарантируется лишь атомарное обновление отдельных сущностей. (Есть, правда, приятные возможности с чтениями/инкрементами за одну операцию). Так что транзакции придется эмулировать: данные разнесены по 20 серверам/дата-центрам всего земного шара.

- Атрибуты. Нередко в NoSQL, в том числе в DynamoDB можно использовать что-то типа:

user=john blog_post_$ts1=12 blog_post_$ts2=33 blog_post_$ts3=69

где

$ts1-3- таймстампы публикаций пользователя в блог. Это позволяет получить список публикаций за один запрос. Но работа программиста увеличивается.

Варианты подходов NoSQL

CA - согласованность данных (Consistency) и доступность (Availability)

Система, во всех узлах которой данные согласованы и обеспечена доступность, жертвует устойчивостью к распаду на секции. Если у вас интернет-магазин, сервера находятся в разных дата-центрах, и в какой-то момент один из серверов "упал", то система становится неработоспособной в целом.

Такие системы возможны на основе технологического программного обеспечения, поддерживающего транзакционность в смысле ACID. Примерами таких систем могут быть решения на основе кластерных систем управления базами данных или распределённая служба каталогов LDAP.

CP - согласованность данных (Consistency) и устойчивость к разделению (Partition tolerance)

Распределённая система, в каждый момент обеспечивающая целостный результат и способная функционировать в условиях распада, в ущерб доступности может не выдавать отклик. Данные пишутся на одну машину, дублируются на другую. Если одна "упала", то можно работать со второй. Устойчивость к распаду на секции требует обеспечения дублирования изменений во всех узлах системы, в этой связи отмечается практическая целесообразность использования в таких системах распределённых пессимистических блокировок для сохранения целостности

AP - доступность (Availability), устойчивость к разделению (Partition tolerance)

Распределённая система, отказывающаяся от целостности результата. Большинство NoSQL-систем принципиально не гарантируют целостности данных. Задачей при построении AP-систем становится обеспечение некоторого практически целесообразного уровня целостности данных, в этом смысле про AP-системы говорят как о "целостных в конечном итоге" (eventually consistent) или как о "слабо целостных" (weak consistent). Наиболее распространённые системы.

Выводы

Прежде чем выбирать для проекта NoSQL хранилище, оцените все возможные призы и риски:

- NoSQL - это часто не что иное, как набор memcached-подобных серверов с надстроенной довольно простой логикой и, соответственно, сохранение данных и простые выборки будут действительно быстрыми. В случае более сложных запросов задачу придется решать на стороне приложения.

- Помните, что по теореме Брюера при реализации придётся выбирать не более двух из трёх свойств: согласованность данных, их доступность и устойчивость к разделению.

- Внимательно изучить документацию по используемому продукту, особенно ограничения, к которым нужно будет аккуратно подготовиться.

- NoSQL создает ложное впечатление, что можно не знать принципы работы SQL. На самом деле, нужно хорошо понимать классическую реляционную теорию, чтобы предвидеть развитие модели данных приложения в NoSQL, угадать варианты денормализации, чтобы приложение не пришлось потом несколько раз переписывать.

С помощью NoSQL вы получите очень надежное, высокодоступное, поддерживающее гибкие схемы репликации современное решение. Однако платить придется жесточайшей денормализацией и усложнением логики работы приложения (в т.ч. эмулировать транзакции, жонглировать тяжелыми данными внутри приложения и тому подобное).

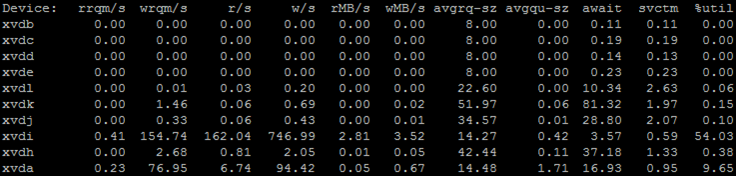

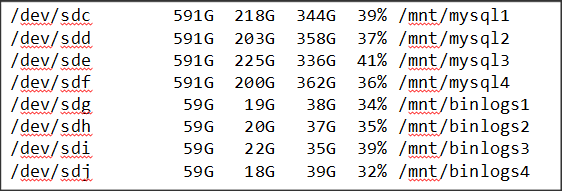

Как выбрать дисковую систему для базы MySQL

Введение

Если вы периодически наблюдаете близкую к 100% утилизацию диска в iostat, то пришло время задуматься над тем, правильно ли вы выбрали дисковую систему.

Самое, как кажется, очевидное решение: надо использовать более быстрые диски - SSD. Но требуется поддержка SSD в серверах (контроллер, драйверы) и это довольно дорого.

Другой подход - использовать не один, а несколько дисков: RAID.

Для высоконагруженных проектов актуальны, прежде всего software RAID, так как такие проекты, как правило, размещаются в облачных структурах. Поэтому предложим методики тестирования для определения конфигурации RAID подходящей для вашего проекта.

Пример тестирования

Пример тестирования проведём на работе с RAID 10. Именно он одновременно и быстрый, и надежный. А, вот, различных его конфигураций - достаточно много.

Собрано 5 стендов:

- single disk - 100 Gb

- RAID 10 - 4 диска по 50 Gb. Добавить через админку Амазона 4 диска, подключить их, назначив соответствующие имена. А затем создать рейд вот так:

# mdadm --create /dev/md0 --level=10 --raid-devices=4 /dev/xvd[g-j]

- RAID 10 - RAID 0 из двух RAID 1 (каждый по 2 диска по 50 Gb). Та же процедура, но итоговый рейд создается в три приема:

# mdadm --create /dev/md0 --level=1 --raid-devices=2 /dev/xvd[g-h] # mdadm --create /dev/md1 --level=1 --raid-devices=2 /dev/xvd[i-j] # mdadm --create /dev/md2 --level=0 --raid-devices=2 /dev/md[0-1]

- RAID 10 - 8 дисков по 25 Gb. Аналогично пункту 2, но только подключаются 8 дисков, а не 4.

# mdadm --create /dev/md0 --level=10 --raid-devices=8 /dev/xvd[g-n]

- RAID 10 - RAID 0 из четырех RAID 1 (каждый по 2 диска по 25 Gb).

# mdadm --create /dev/md0 --level=1 --raid-devices=2 /dev/xvd[g-h] # mdadm --create /dev/md1 --level=1 --raid-devices=2 /dev/xvd[i-j] # mdadm --create /dev/md2 --level=1 --raid-devices=2 /dev/xvd[k-l] # mdadm --create /dev/md3 --level=1 --raid-devices=2 /dev/xvd[m-n] # mdadm --create /dev/md4 --level=0 --raid-devices=4 /dev/md[0-3]

На всех тестовых стендах используйте однотипную файловую систему, например: ext4. Параметры монтирования:

noatime,nodiratime,data=writeback,barrier=0

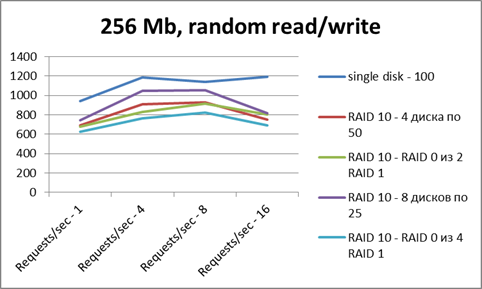

Для тестов лучше использовать sysbench - на файле 256 Мб; режимы - random read, random write, random read/write; разным количеством потоков, от 1 до 16.

- Ось X - число потоков

- Ось Y - число операций в секунду.

По тестам видно, что в чтении все сопоставимо по результатам. Рейд не дает особого преимущества. Но картинка эта - весьма искаженная, так как на результаты очень сильно повлиял файловый кэш (тестовый файл помещается в RAM целиком). По записи рейды несколько проигрывают (сказываются некоторые накладные расходы).

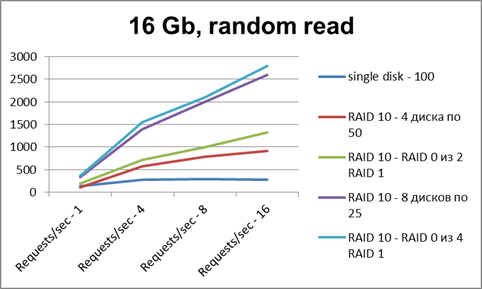

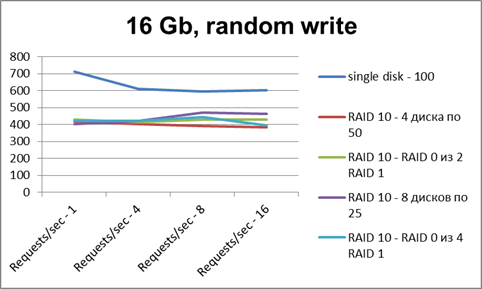

Чтобы определить, какая дисковая система лучше в конкретно вашем случае, необходимо чётко поставить задачу. В нашем случае выбирается дисковая система для базы. Формат хранения данных: InnoDB. Это означает, что работа в основном ожидается с большими файлами (несколько Гб) ibdata.

Значит, типичный профиль нагрузки - random read/write (чтений больше). И вот уже исходя из более понятной реальной задачи делаем новую серию тестов - на файле размером 16 Гб:

Видно, что при чтении один диск сразу упирается в потолок, и увеличение количества потоков не дает прироста производительности. А рейды из 4 дисков на нескольких потоках дают прирост производительности в 3-4 раза. Рейды из 8 дисков — в 6-7 раз.

На запись у рейдов примерно та же картина, что и с одним диском.

Резюме

Типичная работа базы MySQL - random read/write, чтений больше, чем записи. Самые производительные для такой задачи: RAID 10 с большим количеством дисков.

Минус такого решения - в удвоенной стоимости дисков (что при текущей их стоимости не является критичным).

Главное преимущество - у нас есть простое решение (software RAID можно собрать как на физическом сервере, так и в "облаке") для масштабирования производительности дисковой системы.

Программная архитектура веб-систем на Битриксе

Введение

Для программиста не важно, какой использовать framework. Framework - это просто основа, из которой бывает нередко целесообразнее собрать проект, чем писать с нуля. И Bitrix Framework здесь не исключение. Его надо понять, увидеть в целом, оценить его сложность и возможности. Но для ведущего разработчика, который выбирает модель реализации, знание системы важно, иначе трудно ожидать разумного и оправданного выбора архитектуры решения. Рассмотрим несколько вариантов архитектур, позволяющих решать определённые задачи.

Есть два варианта использования Bitrix Framework: "простой" и "сложный". Простой - обычный сайт, без магазина. Магазин - это более сложно, независимо от платформы. Если разработчик делал простые сайты, а потом начинает делать магазин, то ему, возможно, только с неделю нужно осваивать штатный функционал магазина.

Работая с Битрикс, нужно в первую очередь понимать, что можно выжать из стандартных компонентов и шаблонов, а что придётся дописывать.

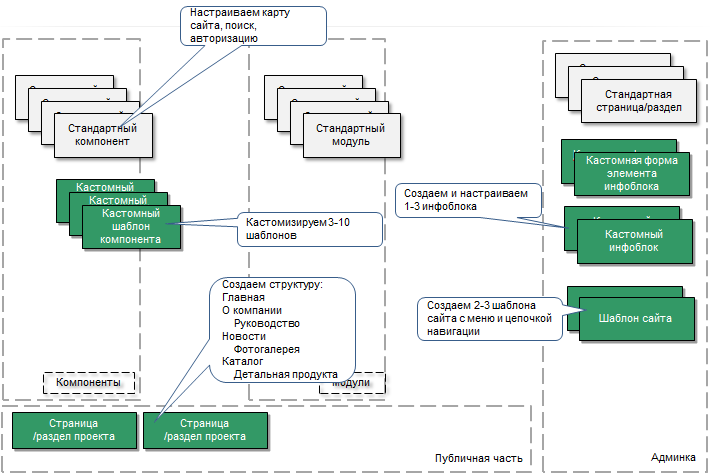

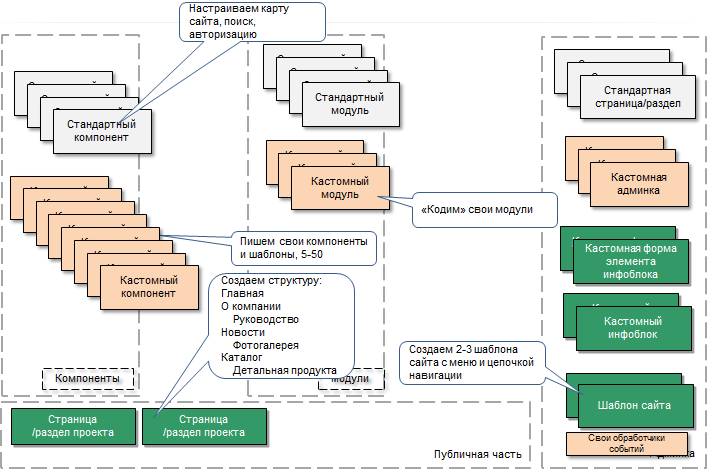

Простой сайт

Модель простого сайта и что должен предусмотреть проектировщик при реализации такого проекта.

В случае простого сайта не производится больших объёмов работ. Как правило, это: создание кастомных шаблонов компонентов, создание структуры сайта, шаблона сайта, несколько инфоблоков. Иногда создаётся кастомная форма добавления элемента инфоблоков.

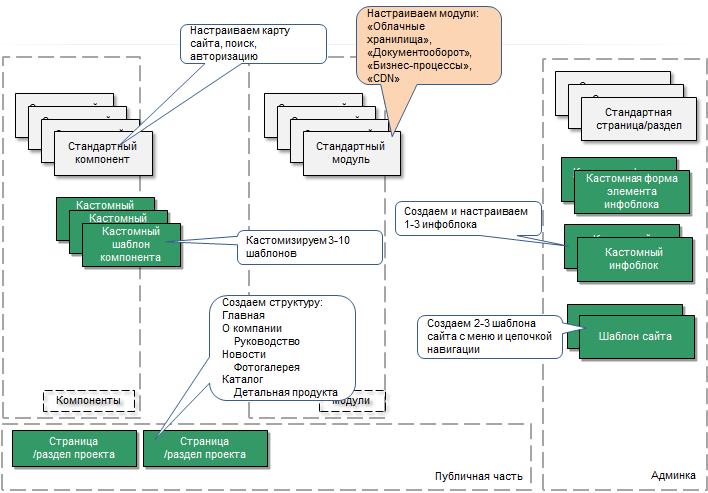

Сайт с объёмным контентом

Одно из главных отличий такого сайта - разделение прав доступа при создании контента с системой проверки и выпуска контента. Другое отличие - большие объёмы данных, к которым нужно обеспечить быстрый доступ и при этом гарантировать их сохранность.

Для хранения большого объёма данных рекомендуется использовать Облачное хранилище. Весь большой контент рекомендуется хранить там.

Для организации поэтапной работы над контентом рекомендуется использовать Документооборот и Бизнес процессы

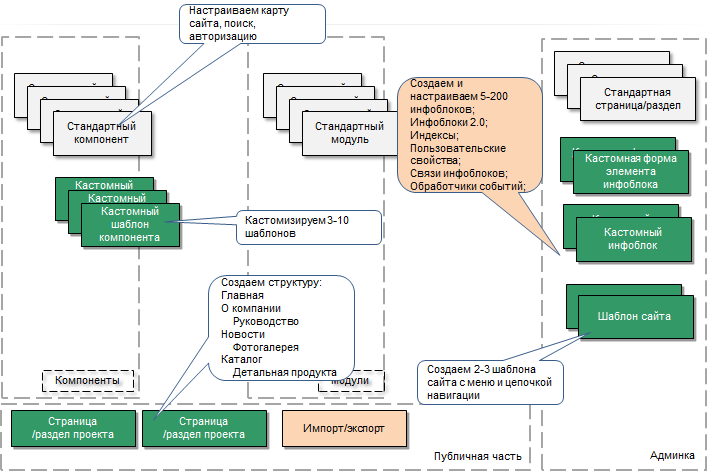

Много данных в инфоблоках

Под "много данных" понимается сотни тысяч и миллионы элементов.

Такой проект "тяжёл" для административной части. Рекомендуется не использовать опцию Совместный просмотр разделов и элементов в настройках модуля Информационные блоки (и настройках самого инфоблока) и обязательно разносить инфоблоки по типам.

Обязательно для таких проектов необходимо:

- Спроектировать модель данных в инфоблоках. Необходимо понять, где нужна денормализация, где - агрегация, где кеширование.

- Описать и реализовать основные запросы к данным из публички (иногда админки). Нужно понять цепочки использования. Например, клиент планирует получать регулярно список новостей (или список элементов в каталоге), и редко (раз в месяц) строить выборки, например, по продажам. Следовательно нужно обеспечить быструю обработку частых запросов, в нашем случае: просмотр списков новостей (каталога), просмотр разделов каталога.

- Реализовать соединение выборок из инфоблоков (joins). Нужно спроектировать модель соединения данных из инфоблоков. В крайних случаях использовать прямые запросы в БД. НО перед этим надо попытаться использовать все доступные средства API.

- Пользовательские свойства. Скорее всего, они будут не совпадающими у инфоблоков, так как контента много и он наверняка разнотипный.

- Кастомные страницы административной части к инфоблокам. При больших объёмах есть смысл в таком проектировании.

- Управляемое и эффективное кеширование данных.

- Экспорт/импорт - JSON, XML, REST, очереди, инкременты.

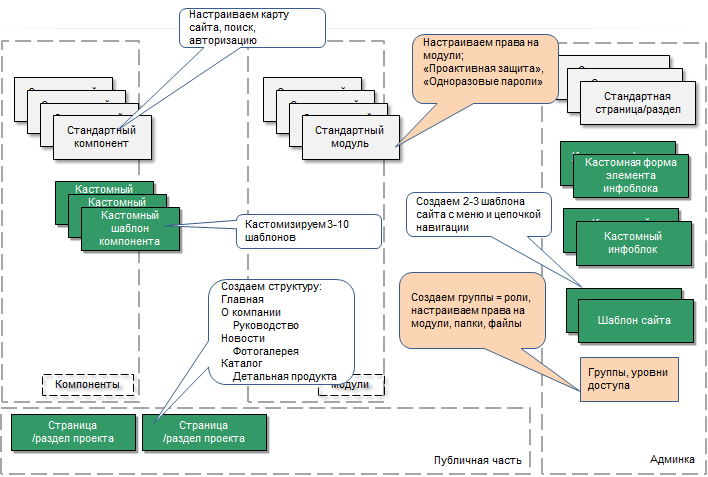

Много ролей

В этом случае на сайте работает много сотрудников, и, как следствие этого, возникают повышенные запросы по безопасности, повышенные требования к разделению доступа.

На таком проекте практически всё делается штатными средствами, надо только понять систему уровней доступа к модулям, папкам, файлам:

- Настраиваем группы и учетные записи пользователей. Настраиваем параметры безопасности группы.

- Настраиваем уровни доступа и доступ к модулям.

- Включается проактивная защита, безопасная авторизация, а лучше - одноразовые пароли.

- Тщательное тестирование складывающейся системы доступа.

- В процессе эксплуатации не забывать отслеживать процесс изменений в системе.

Много кода

Сложный проект, когда функционал выходит за стандартные возможности Bitrix Framework. Основная опасность: желание залезть в ядро Bitrix Framework и изменить его. В этом случае либо все изменения затрутся при обновлении, либо придётся отказаться от обновлений системы. Битрикс поддерживает обратную совместимость API, и любой проект может спокойно обновиться и получать новый функционал.

Кастомизируются или создаются компоненты. Создаются собственные модули с интерфейсом настройки, где хранятся общие классы, библиотеки. Определяем обработчики событий, которые могут менять поведение системы в нужную вам сторону, и пишем в техподдержку Bitrix Framework, если событий не хватает. Создаем свои страницы административного раздела.

В таких проектах ответственность лежит полностью на разработчиках, за Bitrix Framework не спрячешься, надо внимательно рассматривать вопросы производительности, безопасности, аудита.

Интеграция с внешними системами

Задача потребует нетривиального программирования. Используется модуль Веб-сервисы. Если не хватает функционала, то используя REST, SOAP, JSON, XML-RPC API, дорабатываем нужный функционал. Далее реализуете систему синхронизации.

Если данных очень много, то есть смысл создать свои таблицы в MySQL и хранить данные там.

В проектах такого уровня разработчики должны представлять себе администрирование систем. Так, при работе с веб-сервисами нужно понимать XML, TCP-IP, FTP. Как пойдут пакеты, где что пропадает. И кроме этого, в группу разработчиков надо подключать квалифицированного сисадмина как можно раньше.

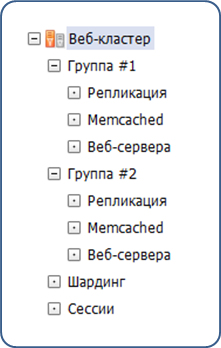

Веб-кластер

Веб-кластер позволяет решать множество задач. При этом в коде вашего проекта ничего делать не нужно, это штатная функция Bitrix Framework.

При проектировании проектировщик должен рассчитать возможную нагрузку на проект и на основании этого сказать, что делать будем кластер. На этом его функции заканчиваются, всё остальное делает система. Нужно только настроить в административной части пулы ресурсов: базы, кэши, обл. хранилища.

Нужно подумать о логике восстановления на базе требований SLA. Надо понять, как сделать так, чтобы максимум 2 минуты система была недоступна. Последнее - резервное копирование. Нужен отдельный регламент.

Особенности проектирования под Битрикс

Проектирование

В данном уроке мы рассмотрим вопросы, связанные не с разработкой, а именно с проектированием под Bitrix Framework.

Проектированием веб-системы может заниматься: менеджер проекта, аналитик или разработчик. При этом учитывайте, что могут возникнуть трудности в связи с тем, что менеджер старается угодить клиенту в ущерб архитектуре, аналитик может сделать слишком много моделей и объектов, а разработчик спроектирует систему так, чтобы удобно было программировать, а не использовать.

В модели проектирования должны быть отражены следующие вещи:

- права и роли (необходимо определить, кто что может делать и где);

- структура контента сайта (список страниц и разделов);

- шаблоны сайта и их динамика;

- меню сайта;

- свойства страниц и разделов, как выполняется управление ими;

- модели данных и работа с ними (инфоблоки, кастомизированные формы административной части)

- компоненты и их размещение на страницах;

- поиск на сайте;

- иногда веб-сервисы;

- выгрузка во внешние системы (при необходимости), синхронизация данных с внешними системами;

- многосайтовость (если используется).

Что должно быть в ТЗ

В техническом задании описывается структура информации проекта - это шаблон сайта (какие в нем включаемые области, типы меню и т.д.) и дерево разделов и страниц. Также описывается и структура самой веб-страницы, какие в ней используются компоненты.

В общих словах, для проектировщика система Bitrix Framework - это набор компонентов, модулей, административная и публичная части. Компоненты подразделяются на стандартные и на свои, кастомные. Модули системы также разделяются на стандартные, которые могут быть расширены кастомными обработчиками событий, и на собственные кастомные, которые могут быть связаны со своей базой данных. В административной части также, помимо стандартных страниц/разделов, могут быть кастомные страницы/разделы, формы инфоблоков, кастомные свойства и настройки инфоблоков. Публичная же часть пишется разработчиком полностью с нуля.

При составлении технического задания обратите внимание, что публичная часть модифицируется очень гибко, а административная часть модифицируется значительно сложнее и только в ограниченных местах. В ТЗ должно быть кратко описано то, что делается с помощью стандартных возможностей (можно ссылаться на официальную документацию и учебные курсы), а весь нестандартный функционал должен быть описан детально. Если необходима разработка кастомных админок (в очень редких случаях), то по ним также составляется детальное описание.

Права и роли в ТЗ

В системе Bitrix Framework права и роли играют ключевое значение. В техническом задании необходимо расписать роли, настраиваемые группы пользователей для этих ролей. Если вам не хватает возможностей стандартных уровней доступа, вы можете добавить свои уровни доступа. Все настроенные права доступа необходимо тщательно тестировать для всех групп пользователей.

Инфоблоки в ТЗ

Как правило, все сущности и данные представляются в Bitrix Framewok инфоблоками и некоторыми объектами из модулей. Поэтому в ТЗ вам необходимо четко определить типы инфоблоков, типы полей инфоблоков. Необходимо расписать модель сущностей, указать, как инфоблоки связаны между собой. Направление связей инфоблоков очень важно с точки зрения производительности. В связи с этим модель сущностей следует обсудить с разработчиком, чтобы не было тяжелых запросов. В случае необходимости можно прибегнуть к денормализации данных.

Также в ТЗ необходимо учесть, кто имеет права на те или иные инфоблоки и разделы. Прописать, какие и для чего используются обработчики событий при работе с инфоблоками.

При проектировании инфоблоков продумывайте, как избежать глубоких выборок. Если у вас часто будут обновляться данные, то, может быть, текущая структура инфоблоков вам не подходит, и ее необходимо заменить (обсудите с разработчиком). Кроме того, необходимо продумать сохранение целостности данных после выполнения некоторых операций, например, удаления.

Компоненты в ТЗ

В ТЗ следует подробно расписать, какие компоненты используются на страницах сайта. Кроме того, полезно указать, из каких инфоблоков тянет данные тот или иной компонент. Для нестандартных компонентов необходимо описать все их свойства. В параметрах компонентов не должно быть настроек, не связанных с логикой работы проекта. Если у компонента сложная логика работы (например, зависящая от настроек модуля), то об этом также необходимо отметить в ТЗ.

Полезные компоненты можно добавлять в свою библиотеку и потом использовать в других проектах. Если компонентов много или кода очень много, то делайте свой модуль, чтобы держать в нем общий код компонентов.

E-commerce в ТЗ

В первую очередь необходимо четко понимать, для чего нужен модуль Интернет-магазин, а для чего - Торговый каталог. Таким образом, в ТЗ должно быть указано, какие именно модули вам нужны, а также нужно ли вам много корзин.

В ТЗ обязательно должна быть подробно описана логика ценообразования, система скидок, как выполняется округление при пересчете цены. Вопросы, связанные с используемыми типами товаров (наборы, комплекты, торговыми предложениями) и остатками, также должны быть освещены в ТЗ.

Статусы заказов полезно описать с помощью диаграммы статусов (диаграммы состояний UML). Платежные системы, службы доставки и все нестандартные настройки других объектов, связанных с магазином, необходимо также добавить в ТЗ. Не следует забывать описывать и используемый формат импорта/экспорта данных магазина.

Веб-сервисы в ТЗ

Нередко в сложных проектах нужно обеспечить взаимодействие магазина, например, с SAP или с 1С, но не по стандартному протоколу обмена. В этом случае может быть удобным использование веб-сервисов, особенно если необходимо быстро передавать изменения. Механизм работы и использование веб-сервисов полезно отображать с помощью диаграмм UML: деятельности (activity), последовательности и др.

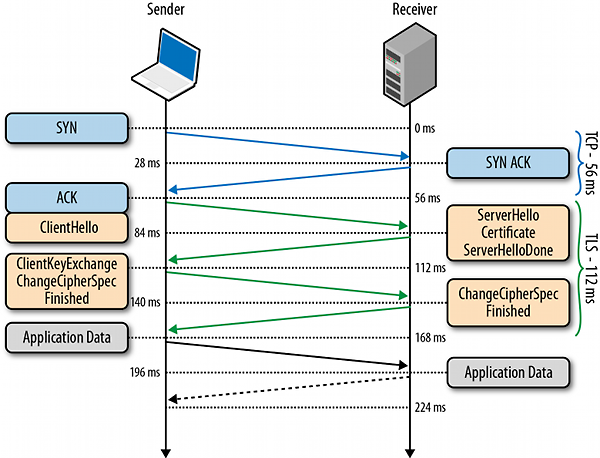

Быстрое веб-приложение

При рассмотрении и оптимизации проекта обычно берут во внимание 2 слабо связанные технологически и социально части: фронтэнд и бэкэнд. И нередко забывают про третью ключевую составляющую - сеть.

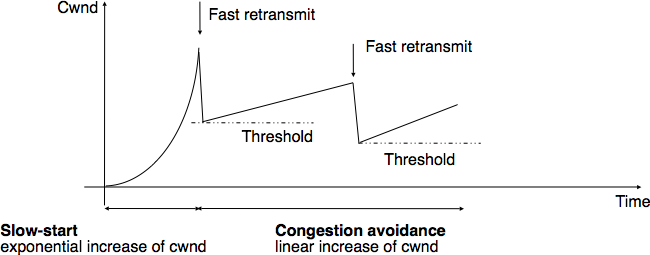

Сеть. Расстояние и пропускная способность сети

Расстояние и пропускная способность сети

Для типичного веб-приложения пропускная способность не особо важна (если только файлы не качать) - гораздо важнее latenсy, т.к. делается много небольших запросов по разным соединениям и TCP-окно просто не успевает раскачаться.

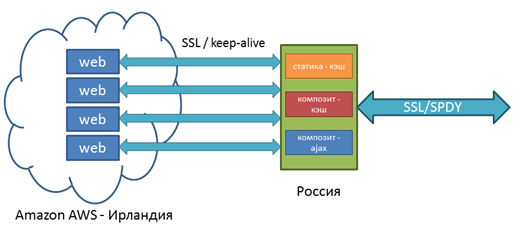

И разумеется, чем дальше клиент от веб-сервера, тем дольше. Но бывает что нельзя иначе или трудно. Именно поэтому придумали:

- CDN

- Динамическое проксирование (CDN-наоборот). Когда в регионе ставится, например nginx, открывающий постоянные коннекты на веб-сервер и терминирующий ssl. Понятно зачем? Именно - в разы ускоряется установление соединений от клиента с веб-прокси (хэндшейки начинают летать), а дальше используется прогретое TCP-соединение.

Еще можно увеличить TCP’s initial congestion window - это нередко помогает, т.к. веб-страничка отдается одним набором пакетов без подтверждения.

"Разогрев" соединения

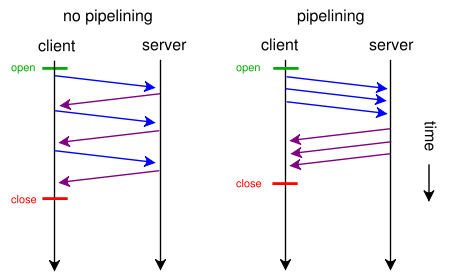

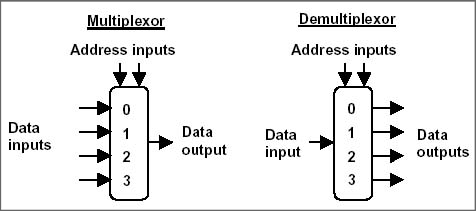

TCP-окошко соединения должно разогнаться сначала. Если веб-страница загружается меньше секунды - окошко может не успеть увеличиться. Средняя пропускная способность сети в мире - немного превышает 3 МБит/с. Вывод - нужно передавать через одно установленное соединение как можно больше, "разогрев" его.

Помочь тут может мультиплексирование HTTP-ресурсов внутри одного TCP-соединения: передача нескольких ресурсов вперемешку как в запросе, так и ответе. Поэтому тут можно использовать HTTP 2.0 или pipelining (но не из браузера, а из приложения напрямую).

Бэкэнд

Приложение

Типичная схема работы веб-приложения состоит из следующих шагов:

- Приложение и/или веб-сервер (php, java, perl, python, ruby и т.п.) - принимает запрос клиента;

- Приложение обращается к БД и получает данные;

- Приложение формирует html;

- Приложение и/или веб-сервер - отдает данные клиенту.

Тут все понятно с точки зрения обеспечения скорости: